ITmedia NEWS >

企業 ・業界 動向 >

OpenAIのAI危険 対策 チームトップが「限界 に達 し」退社 「安全 確保 が後回 しになっている」

» 2024年 05月 18日 07時 49分 公開

[ITmedia]

「

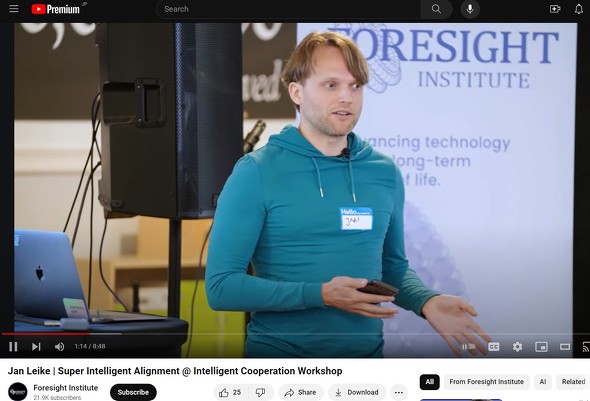

Superalignmentチームはライケ

ライケ

OpenAIは

ライケ

ライケ

関連 記事

OpenAIでアルトマンCEO

OpenAIでアルトマンCEO解任 騒動 の首謀 者 の1人 で共同 創業 者 のサツケバー氏 が退社 へ

OpenAIでの昨年 11月 のCEO解任 騒動 の首謀 者 とみられる共同 創業 者 でチーフサイエンティストのイリヤ・サツケバー氏 が退社 する。「個人 的 に意味 のあるプロジェクトを始 める」としている。 OpenAIを

OpenAIを辞任 したブロックマン社長 、アルトマンCEO解任 の顛末 をポスト

OpenAを辞任 したブロックマン社長 が、アルトマンCEO解任 について「知 っていること」をXにポストした。取締役 会長 だった自身 以外 の全 取締役 がアルトマン氏 にGoogle Meetで解任 をい渡 したという。 OpenAI、“スーパーインテリジェンス”の

OpenAI、“スーパーインテリジェンス”の人類 の敵 化 防止 を目指 す新 チーム立 ち上 げ

OpenAIは、10年 以内 に人間 の知能 を超 える「スーパーインテリジェンス」が実現 すると予測 しており、それを制御 するシステムを構築 するための新 チームを立 ち上 げた。優秀 な人材 を募集 中 だ。 OpenAI、AGI(

OpenAI、AGI(人間 より賢 いAI)へのロードマップを公表 「世界 に深刻 な害 を及 ぼす可能 性 」回避 のために

会話 型 AIサービス「ChatGPT」を手掛 けるOpenAIは、AGI(Artificial General Intelligence;汎用 人工 知能 )実現 のロードマップを公開 した。同社 はAGIを「一般 的 に人間 より賢 いAIシステム」と定義 する。AGIが世界 に害 を及 ぼさないよう、公開 協議 が必要 としている。

関連 リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR