Diskussion:Digitalkamera

| Zum Archiv |

Defekte Weblinks

| Die folgenden Weblinks wurden von einem Bot („GiftBot“) als nicht erreichbar erkannt. |

|---|

|

- http://www.din.de/cmd?level=tpl-artikel&cmstextid=182655&bcrumblevel=1&languageid=de

- Vielleicht ist eine archivierte Version geeignet: archive.org

- http://www.gps-camera.eu/index.php?option=com_content&view=article&id=56

- Vielleicht ist eine archivierte Version geeignet: archive.org

- http://stevesasson.pluggedin.kodak.com/default.asp?item=687843

- Netzwerk-Fehler (6) andere Artikel, gleiche Domain

– GiftBot (Diskussion) 18:24, 26. Nov. 2015 (CET)

53cm?

"Die Elektronik und der Kassettenrekorder waren in einem 53 cm Geräteschrank eingebaut" - wird das nicht eher ein 19"-Rack (oder Schrank) gewesen sein? ETSI werden sie dort in US zu der Zeit wohl eher nicht verwendet haben, außerdem wäre das dann 53,5 cm. Ich kenne keinen "53-cm-Standard", aber die Formulierung legt nahe, es gäbe einen solchen. --Smial (Diskussion) 12:53, 24. Nov. 2018 (CET)

- Ein 19"-Rack hat aber auch nicht 53cm, sondern 48,26 cm. Daher vermute ich, dass ein ETSI-Schrank gemeint ist und die 53,5 cm einfach abgerundet wurden. Es kann sich aber natürlich auch um eine Fehlinformation handeln. --MrBurns (Diskussion) 15:08, 13. Jan. 2020 (CET)

Verständnisfragen zur Auflösung in lp/mm

Die Pixelgröße eines Bildsensors im Verhältnis zur maximalen Auflösung in lp/mm

Hochauflösende Diafilme der analogen Fotografie, wie beispielsweise der Fuji Velvia 50, geben laut Hersteller die Leistung des Films unter idealen Kontrastbedingungen mit 160 Zeilen (80 Linienpaare) pro Millimeter an; eine digitale Kamera bräuchte einen Kleinbild-Vollformat-Sensor mit 87 Megapixeln, um an diese Auflösung heranzukommen.[1]

Daraus ergeben sich die folgenden Werte, die zur Überprüfung der Aussage herangezogen werden können: Bei einem für Kleinbild-Vollformat-Sensoren typischen Seitenverhältnis von 3:2 entsprechen 87 Megapixel einer Auflösung von 11424x7616 Pixeln.[2] Bei einer 1.7047 Zoll Sensorsdiagonale (das entspricht 43,3mm eines typischen KB-Sensors) ergibt sich eine Pixelgröße von 3,15 µm[3] (in Höhe und Breite). Die Formel für Lienenpaare kommt mit diesen Daten auf 79,36 lp/mm,[4] was die Aussage der ersten Quelle stützt.

So weit, so gut. Wie aber ist es möglich, dass ein Kleinbild-Vollformat-Sensor mit gerade einmal 61 Megapixeln im Testlabor auf deutilch über 100 lp/mm kommen kann?[5] Nach Berechnung gemäß der obigen Quellen liegt die Pixelgröße des Sensors in Höhe und Breite bei 3,75 µm[3] (9600x6400 Pixel). Mehr als 67 lp/mm sollten mit diesem Farbsensor nicht erfasst werden können (500 / (3,75µm * 2) = 500 / 7,5 = 66,66 lp/mm).[4] Das als Quelle 5 genannte Testlabor ist nicht das Einzige, dass im Ergebnis deutlich höhere Auflösungswerte ermittelt. Aber wie kann das sein? Entweder sind die Berechnungen aus den ersten vier Quellen falsch oder die Testergebnisse liegen daneben (was eher unwahrscheinlich ist) oder ich verstehe etwas nicht richtig. --

- ↑ Alte Objektive an neuen Kameras verwenden, pcwelt.de, Autor: David Wolski

- ↑ Berechnungen bei optischen Geräten auf rechneronline.de

- ↑ a b Übereinstimmend mit Sensorberechnungen auf vision-doctor.com zur Berechnung der Pixelgröße in µm (mit Nachkommastellen) sowie Pixelgrößen Rechner auf lcdtech.info als zweite Referenz (ohne Nachkommastelle, dafür mit MP-Berechnung)

- ↑ a b Formel für Farbsensoren: Linienpaare = 500 / (Pixelgröße in µm * 2); Formel für Monochromsensoren: Linienpaare = 500 / (Pixelgröße in µm * 1,41) gemäß OptoWiki

- ↑ Testbericht: Sony Alpha 7R IV, digitalkamera.de, Seite 2, 15.11.2019, getestet am Objektiv „Sony FE 35 mm F1,8“ und „Sony FE 24-105 mm F4 G OSS“, Autor: Benjamin Kirchheim

- Bei einem Bildsensor im Kleinbildformat mit 67 Millionen Bildpunkten ist der Abstand der Bildmittelpunkte mit 5,3 Mikrometern so groß wie der Durchmesser eines Beugungsscheibchens, das bei einem Objektiv mit der Blendenzahl 4 erzeugt wird. Bei größeren Blendenzahlen ist der Durchmesser der Beugungsscheibchen größer. Davon völlig unabhängig ergeben sich durch verschiedene Abbildungsfehler Auflösungsbegrenzungen, die mit kleinerer Blendenzahl und zu den Bildecken hin zunehmen. Ein sehr gut korrigiertes Objektiv für eine Kleinbildkamera hat auf der optischen Achse keine Aberrationen, die die optische Auflösung begrenzen.

- Der Kontrast ergibt sich aus einem Verhältnis der Helligkeiten zweier benachbarten Punkte. In einem perfekten Bild ist dieser genauso groß, wie beim aufgenommen Original, und das Verhältnis dieser beiden Kontraste ist demzufolge eins (anders ausgedrückt: die Kontrastübertragung beträgt 100 Prozent).

- Aus photographischer Sicht ist es unwichtig, ob bei großen Ortsfrequenzen (Maßeinheit Linienpaare pro Längeneinheit) noch ein wenig Kontrast übertragen wird. Das interessiert nur "Pixelpeeper" und hat keinen praktischen Nutzen. In einem perfekten Bild müssen bei den erkennbaren Ortsfrequenzen 100 Prozent Kontrastübertragung vorhanden sein - nicht weniger, aber bitte auch nicht mehr, weil der Kontrast digital angehoben wurde, damit das Bild schärfer und ansprechender aussieht. Die physiologisch erkennbaren Ortsfrequenzen liegen zwischen 0 und ungefähr 1000 Linienpaaren pro Bildhöhe (in einem Kleinbild mit 24 Millimetern Höhe wären das maximal 42 Linienpaare pro Millimeter beziehungsweise 6 Millionen Bildpunkte), wobei das menschliche Auge bei den angegebenen Werten nur noch 10 Prozent des tatsächlich vorhandenen Kontrastes erkennen kann. Die größte Kontrastempfindlichkeit liegt bei einer Ortsfrequenz von zirka 200 Linienpaaren pro Bildhöhe. Der Bildeindruck wird von den sichtbaren Kontrasten im Ortsfrequenzbereich zwischen 50 und 500 Linienpaaren pro Bildhöhe dominiert, wo der wahrnehmbare Kontrast oberhalb von 50 Prozent liegt.

- Wie auch immer, der Bildsensor einer Kleinbildkamera mit einem Pixelpitch von 5,3 Mikrometern kann gut 2200 Linienpaare pro Bildhöhe beziehungsweise 94 Linienpaare pro Millimeter auflösen, und das noch nicht einmal mit der vollen Farbinformation, weil in jedem Bildpunkt nur eine einzige Primärfarbe gemessen wird. Bei dieser Ortsfrequenz ist die Wahrnehmung des menschlichen Auges praktisch null, und zudem liefern die meisten (auch teuren) Objektive hier eine sehr dürftige Kontrastübertragung. Siehe zum Beispiel [1] - beim Sony FE Sonnar 35mm f/2,8 (Listenpreis 949 Euro) ist die Kontrastübertragung (MTF) hier zum Beispiel bei lediglich 50 Linienpaaren pro Millimeter mit 55 Prozent auf der optischen Achse und mit 20 Prozent in den Bildecken angegeben. Bei solchen "dürftigen" Kontrastübertragungen sollte man sich gar nicht erst Gedanken über die Bildqualität bei 100 Linienpaaren pro Millimeter mehr machen, und das schon gar nicht, wenn es sich bei den bewerteten Zahlen aus der digitalen Bildanalyse mehr um Artefakte der bildtechnischen Manipulation beim Demosaicing und der digitalen Kontrastüberhöhung handelt, als um irgendeine reale optische Information. Ferner gibt es bei Bildsensoren mit solch großer Pixelzahl Abertausende von fehlerhaften Pixeln (Hotpixel), die gar nichts oder zumindest fast nichts zur Kontrastübertragung beitragen können.

- Fazit: mögen die Bildsensor-Tester dieser Welt endlich aufhören, die Pixel auf den Bildsensoren zu zählen und daraus völlig praxisferne Testurteile zu generieren. Eine sehr gute und praxistaugliche Kamera erzeugt Bilder mit 8 Megapixeln (siehe auch 4K (Bildauflösung)), wobei zwei beliebige benachbarte Bildpunkte bei allen drei Primärfarben und auch in den Bildecken einen reellen Kontrast zeigen (mit anderen Worten: die Kontrastübertragungsfunktion beträgt 100 Prozent). Die dafür erforderlichen Objektive sind erheblich teurer als die Bildsensoren, die das leisten können. Wenn alle Objektive eine solche Kontrastübertragung liefern würden wie dieses hier [2] (Listenpreis 3000 Euro), wäre es für Photographen wie in einem schönen Traum... --Bautsch 23:43, 23. Dez. 2019 (CET)

- Für kleinere Bildausschnitte, sollten genau aus den oben erwähnten Erwägungen übrigens besser Objektive mit kleinerem Bildwinkel (respektive längerer Brennweite) verwendet werden, anstatt im aufgenommenen Bild einen digitalen Zoom durchzuführen. Die niedrigen (schlechten) Kontrastübertragungswerte des Bildes verschieben sich hierbei nämlich von den höheren Ortsfrequenzen nach links hin zu den kleineren und somit besser wahrnehmbaren Ortsfrequenzen. --Bautsch 00:06, 24. Dez. 2019 (CET)

Bautsch, danke für Deine schnelle und ausführliche Antwort. Du gehst in Deiner Erklärung beispielhaft von einer Pixelgröße von 5,3 µm bei 94 lp/mm aus. Wenn ich die Formel von oben nehme, dann komme ich bei dieser Pixelgröße auf 47 lp/mm (500 / (5,3 lp/mm * 2) = 500 / 10,6 = 47,16 lp/mm)[1] und nicht auf 94 pl/mm. Das bedeutet also, dass diese Berechnungsformel Deiner Meinung nach falsch ist? --

- ↑ Formel für Farbsensoren: Linienpaare = 500 / (Pixelgröße in µm * 2); Formel für Monochromsensoren: Linienpaare = 500 / (Pixelgröße in µm * 1,41) gemäß OptoWiki

Nachtrag: Ah, ich sehe gerade meinen Fehler in der Antwort. Du redest vom Pixelabstand, nicht von der Pixelgröße. Wie groß ist denn der Sensorpixel aus Deinem Beispiel? Das ist wichtig für die Antwort auf meine Frage von oben.

- Der Abstand der Pixelmittelpunkte und die Pixelgröße sind identisch, wenn zwischen der Pixeln kein elektrisch isolierender Steg wäre. Da ist natürlich einer, dieser Umstand wird allerdings durch die Verwendung von Mikrolinsenfeldern kompensiert, die auch das Licht über den (lichtunempfindlichen) Stegen zur lichtempfindlichen Pixelmitte lenken. Das kann sowohl für die Lichtausbeute als auch für die Ortsauflösung ignoriert werden.

- Der Faktor zwei zwischen den beiden Formeln beruht sicherlich auf der in der Optik-Branche verbreiteten Faustformel, dass Bayer-Sensoren nur ungefähr eine halb so große Farbauflösung liefern wie sie Pixel haben, da jedes einzelne Pixel nur eine der drei Primärfarben rot, grün und blau erfasst. Siemens-Sterne sind in der Regel jedoch ohne Farben, so dass die Firmware der Kameras beim sogenannten Demosaicing alle Farben wegrechnet und dafür möglichst viel schwarz-weiß Kontraste hinrechnet. Dadurch können sogar bei Ortsfrequenzen jenseits der Nyquist-Grenze rein rechnerisch noch Kontraste auftreten, die im Objekt (Siemens-Stern) zwar durchaus vorhanden sein können, vom Objektiv aber gar nicht übertragen wurden - neudeutsch würde man das wohl als "Fake" bezeichnen. Diese Verfahren dienen dazu, Bilder mit geringer Auflösung ansehnlicher zu machen (Smartphone-Kameras machen das heutzutage "vorbildlich") oder numerische Ergebnisse von Testtafelaufnahmen mit hoher Bildauflösung bis zur Auflösungsgrenze der Bildsensoren hochzutreiben, ohne dass dies objektiv (oder auch wörtlich "durch das Objektiv") irgendeine Verbesserung der optischen Abbildung mit sich bringt. Deswegen kritisierte ich dieses früher durchaus angebrachte, heute aber obsolete Messverfahren dahingehend, dass man einfach auch gleich die Pixel auf dem Bildsensor zählen kann, ohne eine Messung durchzuführen !

Du schreibst, Zitat: "Fazit: mögen die Bildsensor-Tester dieser Welt endlich aufhören, die Pixel auf den Bildsensoren zu zählen" Aber genau das tun sie nicht. Ohne die Sensorauflösung zuvor zu ermitteln untersuchen sie schlicht das Foto und berechnen dann daraus die effektive Auflösung im Zusammenspiel von Optik und Sensorik (zum Beispiel per Siemensstern). Meine Frage von oben zielt darauf ab, dass sie im Ergebnis mitunter eine weitaus höhrere optische Auflösung errechnen, als die Sensorauflösung zu erfassen vermag. Ich will herausfinden, ob die Formel für die vom Sensor maximal erfassbare optische Auflösung gemessen an der Pixelgröße wirklich korrekt ist oder ob die Testergebnisse/die Messmethoden fehlerhaft sind oder ich einfach nur etwas nicht richtig verstanden habe. Deine Antwort ist interessant, hilft mir diesbezüglich aber leider nicht weiter. Gruß, --

- Die oben von mir beschriebenen Verfahren zur Bildaufbereitung durch die Kameras und zur "Messung" von Siemens-Sternen dienen bei Smartphone-Kameras mit 12 Megapixel oder bei Systemkameras mit 20, 40 oder gar 60 Megapixelkameras vor allem dazu, möglichst "gute" Ergebnisse zu liefern. Die Dead-Leaves-Methoden (siehe auch ISO 12233 ([3]) oder [4]) liefern da erheblich praxisnähere Ergebnisse, da die Testtafeln mehrfarbig sein können, und keine regelmäßigen Muster haben, die von der automatischen Bildaufbereitung ohne weiteres systematisch verbessert werden können. Hierbei ergeben sich dann auch keine fiktiven Kontraste bei unsinnig hohen Ortsfrequenzen... --Bautsch 13:19, 24. Dez. 2019 (CET)

Das ist sehr informativ und ich würde gerne auf so vieles davon näher eingehen. Wenn Du, Bautsch, die Geduld davür aufbringen kannst, würde ich das gerne nach Klärung der obigen Frage nachholen. Das hier entwickelt sich für mich zu einem wirklich interessanten Gespräch...

Doch zunächst einmal: Du schreibst, Zitat: "Der Abstand der Pixelmittelpunkte und die Pixelgröße sind identisch... [der elektrisch isolierender Steg dazwischen wird] durch die Verwendung von Mikrolinsenfeldern kompensiert." Du gehst in Deinem Beispiel also von den foglenden Daten aus: KB-Sensor mit 67 MP, woraus 5,3 µm Pixelgröße und 94 lp/mm resultieren (mehr kann der Sensor also selbst unter idialsten Bedingungen nicht erfassen).

Meine eingangs genannten Quellen kommen bei den Abmessungens eines KB-Sensors zum folgenden Ergebnis: Aus 67 MP resuliteren eine Auflösung von 10025x6683 Pixeln[1] (3:2) und eine Pixelgröße von 3,59 µm[2] (in Höhe und Breite). Die Formel für Lienenpaare kommt mit diesen Daten auf 70 lp/mm bei Farbsensoren (500 / (3,59µm * 2) = 500 / 7,18 = 69,63 lp/mm) bzw. bei Monochromsensoren auf 99 lp/mm (500 / (3,59µm * 1,41) = 500 / 5,06 = 98,81 lp/mm).[3]

- ↑ Berechnungen bei optischen Geräten auf rechneronline.de

- ↑ Übereinstimmend mit Sensorberechnungen auf vision-doctor.com zur Berechnung der Pixelgröße in µm (mit Nachkommastellen) sowie Pixelgrößen Rechner auf lcdtech.info als zweite Referenz (ohne Nachkommastelle, dafür mit MP-Berechnung) - bei einer 1.7047 Zoll Sensorsdiagonale (das entspricht 43,3mm eines typischen KB-Sensors mit einer Seitenlänge von 24 x 36 mm)

- ↑ Formel für Farbsensoren: Linienpaare = 500 / (Pixelgröße in µm * 2); Formel für Monochromsensoren: Linienpaare = 500 / (Pixelgröße in µm * 1,41) gemäß OptoWiki

Wie kommt es zur Diskrepanz der jeweils berechneten Pixelgröße (5,3 µm vs 3,59 µm)? Ein Zahlendreher (5,3 statt 3,5)?

- Sorry, da habe ich mich ganz offensichtlich vertippt und / oder verrechnet, denn bei 6683 Zeilen auf der Kleinbildhöhe von 24 Millimetern ergeben sich 24 Millimeter / 6683 = 3,6 Mikrometer. --Bautsch 16:09, 26. Dez. 2019 (CET)

Deine 97 lp/mm liegen nahe an den von mir berechneten 99 lp/mm, weshalb ich davon ausgehe, dass Du mit den Werten für Monochromsensoren gerechnet hast. Üblicherweise sind Farbsensoren in den Kameras verbaut (mal von einigen Leica Kameras abgesehen). Die Bayer-Farbsensoren erfassen, wie Du bereits geschrieben hast, rot, grün und blau mit je einem separaten Pixel, die dann zu einem Farbwert zusammengerechnet werden. Daher die Abweichung der Auflösung zwischen Farb- und Monochromsensoren. Allerdings wäre es theoretisch denkbar, jeden Pixel, der ursprünglich für nur eine Farbe zuständig ist, zur Erfassung eines eigenständigen Pixels heranzuziehen, wenn der Farbsensor nur noch Monochrom abbilden soll. Dadurch würde sich die Auflösung eines Farbsensors auf die Auflösung eines Monochromsensors erhöhen. Genügend Rechenkraft in der Kamera vorausgesetzt, ließen sich auf diese Weise sogar Farbaufnahmen hin zur höheren Monochromauflösung berechnen, indem man beide Aufnahmemethoden "übereinander legt" und zu seinem Bild zusammenfügt. Das ist aber nur meine ganz persönliche Theorie. Huawei macht soetwas in der Art in ihrem P20 Pro - jedoch greifen sie dabei auf einen zusätzlichen monochromen Sensor zurück, nehmen also nicht einen einzelnen Farbsensor dafür. Deiner Benutzerseite entnehme ich, dass Du am Optischen Institut der Technischen Universität Berlin promoviert hast und jetzt hauptberuflich als wissenschaftlicher Mitarbeiter bei der Stiftung Warentest beschäftigt bist. Daher meine Frage gerichtet an Deine praktische Erfahrung, ob ich mit meiner Theorie richtig liege, in der Hoffnung, dass wir uns damit nicht auf den Weg der Theoriefindug begeben... Das wäre dann nämlich eine plausible Erklärung auf meine eingangs gerichtete Frage. Gruß, --

- Keine Sorge, es handelt sich nicht um Theoriefindung, sondern um seit über einhundert Jahren bekannte und veröffentlichte Fakten.

- Ein Bayer-Sensor kann bunte Objekte übrigens nicht monochrom abbilden, da in jedem Bildpunkt nur eine Primärfarbe gemessen wird, die für die tatsächliche Objektfarbe und -helligkeit nicht notwendiger Weise repräsentativ ist. Unter der (bei Siemens-Sternen meist zutreffenden) Annahme, dass das Objekt monochrom ist, kann die Farbinformation verworfen und nur die Helligkeit ausgewertet werden. Gut für die Bewertung von sehr geringen Kontrasten an kleinen Strukturen, aber für die Bildqualität bei realen Objekten liefert das wegen der fehlenden Farbauflösung in der Regel keinen Mehrwert, und schon gar nicht, um Bildausschnitte zu vergrößern oder Großplakate herzustellen, die auch aus der Nähe betrachtet als ansehnlich empfunden werden. --Bautsch 16:09, 26. Dez. 2019 (CET)

- Du schreibst "kann die Farbinformation verworfen und nur die Helligkeit ausgewertet werden". Nehmen wir ein Bild, dass per Farbsensor aufgenommen wurde und daher unter idealsten Bedingungen auf diesem Sensor optisch 70 lp/mm erfaßt hat (mehr geht nicht). Bedeutet das jetzt, dass ich in meinem Computerprogramm lediglich die Farbsättigung auf 0 setzten muss (=s/w-Foto) und schon sind es 99 lp/mm? Das verstehe ich nicht; das sollte nach meinem bisherigen Verständnis so nicht funktionieren. *grübel* Gruß. --

η eonZERO 18:43, 26. Dez. 2019 (CET)

- Du schreibst "kann die Farbinformation verworfen und nur die Helligkeit ausgewertet werden". Nehmen wir ein Bild, dass per Farbsensor aufgenommen wurde und daher unter idealsten Bedingungen auf diesem Sensor optisch 70 lp/mm erfaßt hat (mehr geht nicht). Bedeutet das jetzt, dass ich in meinem Computerprogramm lediglich die Farbsättigung auf 0 setzten muss (=s/w-Foto) und schon sind es 99 lp/mm? Das verstehe ich nicht; das sollte nach meinem bisherigen Verständnis so nicht funktionieren. *grübel* Gruß. --

- Bei einer farblosen Vorlage spricht jedes Farbpixel eines Bayer-Sensors an, wenn das Objekt Licht emittiert. Wenn kein Licht emittiert wird, dann registriert das entsprechende Pixel den Wert für Schwarz. Wenn eine homogene rote, grüne oder blaue Fläche aufgenommen wird, dann sprechen jedoch nur die jeweiligen Pixel des Bayer-Sensors an, die beiden anderen Primärfarben registrieren dann aber kein Lichtsignal. Wenn die Farbsättigung im Bildbearbeitungsprogramm nach der Aufnahme auf Null gesetzt wird, ergibt sich ein grau-schwarzes Muster, aber keine homogene Fläche, in der alle Bildpunkte die gleiche Helligkeit haben, so wie in der Vorlage. Ein realistisches, homogenes Bild erhält man hier nur mit einem monochromen Bildsensor (also mit einem ohne Farbmosaik). --Bautsch 23:32, 26. Dez. 2019 (CET)

- Ändernt sich dadurch die messbare optische Auflösung von 70 hin zu 99 lp/mm? Gruß, --

η eonZERO 00:06, 27. Dez. 2019 (CET)

- Ändernt sich dadurch die messbare optische Auflösung von 70 hin zu 99 lp/mm? Gruß, --

- Nach der oben genannten Faustformel kann man mit einem Bayer-Sensor nur die halbe Farbauflösung erreichen, so dass die theoretisch erreichbare in beiden Richtungen (horizontal und vertikal) um den Faktor Wurzel-2 verringert wird, insgesamt als um den Faktor 2. 99 / 70 entspricht diesem Faktor Wurzel-2. Aber ich möchte noch einmal ausdrücklich darauf hinweisen, dass optische Tiefpässe, die Beugungsbegrenzung durch das Objektiv und Abbildungsfehler die praktisch erreichbare Auflösung in der Regel bei deutlich niedrigeren Ortsfrequenzen limitieren. Bei Bayer-Sensoren mit unsinnig vielen Pixeln, wird der optische Tiefpass meistens weggelassen, weil die Beugungsbegrenzung so stark ist, dass ein denkbar kleiner Objektpunkt (wie zum Beispiel ein Fixstern) auf dem Bildsensor sowieso immer mehrere Pixel beleuchtet. Weitere Information in meinem Wikibook: Ortsfrequenz, Beugungsbegrenzung, Bildsensoren. --Bautsch 09:43, 28. Dez. 2019 (CET)

- Du schreibst "[...] so dass die theoretisch [xxx] erreichbare in beiden Richtungen [...]"; an der Stelle von xxx hast Du ein Wort verschluckt, sodass ich den Satz nicht verstehe. Meist Du "Auflösung"? Wenn ja, dann bestätigst Du mit diesem Satz - wenn ich das richtig verstehe - lediglich, dass die Rechnung mit den 70 zu 99 lp/mm stimmt, bezogen auf Farb- und Monochrom-_Sensoren_. Meine Frage lautete jedoch, ob ein _auf einem Farbsensor erfaßtes Bild_ an optischer Auflösung gewinnt (von 70 hin zu 99 lp/mm), wenn man die Farbhinformation daraus herausrechnet, es also zu einem Monochrom-Bild umwandelt.

- Ich bin heute leider den ganzen Tag unterwegs, weshalb ich Deine oben verlinkten Artikel erst morgen lesen werde. Ich freue mich schon darauf... Gruß, --

η eonZERO 06:52, 29. Dez. 2019 (CET)

- Ich bin heute leider den ganzen Tag unterwegs, weshalb ich Deine oben verlinkten Artikel erst morgen lesen werde. Ich freue mich schon darauf... Gruß, --

- Die "theoretisch erreichbare" bezieht sich unmittelbar auf "Farbauflösung" meines ersten Satzes. Bei einem Bayer-Sensor kann die Farbinformation nicht herausgerechnet werden, da die Farbinformation inhärent erfasst wird. Durch das Demosaicing (Anti-Aliasing) werden zwar störende farbige Artefakte entfernt, dabei geht ohne Kenntnis und Annahmen zum photographierten Objekt jedoch Bildinformation verloren. Da Siemens-Sterne keine Farbinformation enthalten, kann beim Demosaicing keine Farbinformation verloren gehen, und durch die Annahme und die (rechnerische) Fortsetzung von schwarz-weißen Kanten zur Mitte des Siemens-Sterns hin wird eine optische Auflösung suggeriert, die bei der optischen Abbildung gar nicht erreicht wurde und die daher bei realen farbigen Objekten (also keinen Siemens-Sternen) in der Abbildung auch gar nicht erreicht wird. Das Einzige, was damit erreicht wird, sind scheinbar hohe Ortsfrequenzen bei der Kontrastübertragung mit sehr geringen Bildkontrasten (zum Beispiel nur 10 Prozent Bildkontrast an perfekten schwarz-weißen Objektkanten). Diese zu Bewerten und zu Beurteilen, um etwas über die Bildqualität einer Digitalkamera auszusagen, ist nicht zielführend, weil sie erstens nicht real sind und zweitens der geringe bewertete Kontrast gar nicht für hochwertige Bilder ausreichend ist. --Bautsch 09:41, 29. Dez. 2019 (CET)

- Ah, so verstehe ich das. Danke für Deine Erklärung. Das bedeutet also, dass ein monochormes Objekt, dass mit einem Farbsensor aufgenommen wurde, ebenfalls die 99 lp/mm erreichen kann (max. - bei dem Sensor aus Deinem Beispiel). Richtig? Das erklärt vieles. Danke. :o)

- Ich war viel länger unterwegs, als ursprünglich gedacht, muss auch gleich wieder weg und werde erst am 3.1. wieder verfügbar sein. Deine oben verlinkten Artikel konnte ich leider(!) noch ncht lesen. Werde ich aber nachholen und mich dann melden. Ich wünsche Dir einen guten Rutsch ins neue Jahr. Vielen herzlichen Dank für Deine Geduld mit mir und meinen Fragen. Gruß, --

η eonZERO 17:30, 31. Dez. 2019 (CET)

- Ich war viel länger unterwegs, als ursprünglich gedacht, muss auch gleich wieder weg und werde erst am 3.1. wieder verfügbar sein. Deine oben verlinkten Artikel konnte ich leider(!) noch ncht lesen. Werde ich aber nachholen und mich dann melden. Ich wünsche Dir einen guten Rutsch ins neue Jahr. Vielen herzlichen Dank für Deine Geduld mit mir und meinen Fragen. Gruß, --

Wow! Das Buch, dass Du, Bautsch, geschrieben hast, ist wirklich toll. Digitale bildgebende Verfahren mag von Dir als Lehrbuch gedacht sein, aber aus meiner Sicht ist es nicht nur für Studenten geeignet, sondern auch für interessierte Laien wie mich. Und es ist frei verfügbar bei wikibooks.org. Ich bin beeindruckt. Hut ab.

Ich weiß dass es unhöflich ist so lange nicht zu antworten und dafür entschuldige ich mich. Ich war viel später zurück als ursprünglich geplant. Bei mir ist derzeit viel los. So konnte ich Montag die Kapitel "Grundlagen", "Bildaufnahme" und einen Teil von "Lichtwandlung" lesen; heute (Donnerstag) kam ich erst zu den Rest des Lichtwandlungs-Kapitels. Da das ein Wiki ist, habe ich dort einige kleinere Korrekturen vorgenommen. Mache einfach Rückgängig, was Dir nicht gefällt.

Um zum Thema zurückzukehren: Es wäre nett, wenn Du mir sagen könntest, ob ich Dich oben wirklich richtig verstanden habe, da sich daraus dann Folgefragen ergeben: Ein monochormes Objekt (wie der Siemensstern), dass mit einem Farbsensor erfasst wurde, kann also ebenfalls die 99 lp/mm erreichen (max. - bei dem Sensor aus Deinem Beispiel)? Gruß, --

- Ich freue mich, wenn ich auf diesem Weg erfahre, dass das Wikibook gelesen wird und einen Nutzen hat. Ich freue mich auch, wenn dort Korrekturen vorgenommen werden und habe keinerlei Unhöflichkeit empfunden, auch nicht wegen vermeintlich später Antworten.

- Wenn wir uns auf die folgende Formulierung einigen können, bin ich dabei: "Bei einem schwarz-weißen Objekt, dass mit hinreichender optischer Auflösung des verwendeten Objektivs und einem Bayer-Sensor erfasst wurde, kann unter Berücksichtigung des Wissens, dass das Objekt unbunt ist, die volle Bildauflösung des Bildsensors ausgeschöpft werden." --Bautsch 14:27, 9. Jan. 2020 (CET)

- Danke für Dein Verständnis bezüglich der späten Antworten; das wird in der nächsten Zeit leider auch nicht besser werden.

- Dank Deiner Antwort kann ich jetzt mit konkret berechneten Daten arbeiten, die zu meiner weiter unten stehenden Folgefrage führen: Dein Beispiel bezog sich auf 67 Megapixel, aber ich möchte auf einen 61 Megapixel-Kleinbildsensor eingehen, da er zu einem ganz konkreten Fall passt. Er hat eine Pixelgröße von 3,75 µm in Höhe und Breite. Das entspricht genau der Größe der Lichtpunkte (genauer des Beugungsscheibchens) des (in diesem Beispiel absolut fehlerfreien) Objektivs bei Blende F2.8. Unter den von Dir genannten Bedingungen könnten damit 95 lp/mm erfaßt werden. Das entspricht der maximal möglichen Auflösung sowohl des F2.8'er Objektivs als auch des Sensors. Ich setze darüber hinaus die folgenden Gegebenheiten voraus (bitte korrigiere mich hier, falls ich damit falsch liege):

- a) Unter den von Dir genannten Bedingungen erfaßt jeder Sensorpixel je einen Lichtpunkt. Daraus folgt:

- b) Die Auflösung von 95 lp/mm läßt sich durch die Firmware rechnerisch nicht weiter erhöhen, jedenfalls nicht ohne damit die Megapixelauflösung der Bilddatei zu erhöhen.

- c) Was passiert bei Verwendung eines fehlerfreien Objektivs mit kleinerem Blendenwert und somit höherer optischer Auflösung?: Mit einem 61-MP-KB-Sensor können noch immer nicht mehr als 95 lp/mm erfaßt werden.

- d) Was passiert bei Verwendung eines fehlerfreien Objektivs mit größeren Blendenwert und somit niedrigerer optischer Auflösung?: Die erfaßte optische Auflösung sinkt, könnte im Ergebnis unter Idealbedingungen aber wieder auf max. 95 lp/mm hochgerechnet werden (die oben angesprochenen Firmwaretricks).

- Das bereits erwähnte Testlabor ermittelt aus einem Foto, das mit einem 61 MP-Kleinbildsensor aufgenommen wurde, jedoch eine Auflösung von 101 lp/mm. Bei einem Foto eines 50(!) MP großen KB-Sensor (8660x5774 Pixel = 4,16 µm = max. 85 lp/mm wären hier möglich) kommen sie sogar auf 102 lp/mm. Wie ist so etwas möglich? --

η eonZERO 23:20, 10. Jan. 2020 (CET)

- Das bereits erwähnte Testlabor ermittelt aus einem Foto, das mit einem 61 MP-Kleinbildsensor aufgenommen wurde, jedoch eine Auflösung von 101 lp/mm. Bei einem Foto eines 50(!) MP großen KB-Sensor (8660x5774 Pixel = 4,16 µm = max. 85 lp/mm wären hier möglich) kommen sie sogar auf 102 lp/mm. Wie ist so etwas möglich? --

- Nachtrag: Anders formuliert haben wir oben festgestellt, dass die Formlen für die Berechnung der lp/mm sowohl bei Deiner als auch bei meiner Berechnung im Ergebnis übereinstimmen, obwohl wir unterschiedliche Rechenwege benutzt haben. Das deutet darauf hin, dass der Fehler nicht in den Formeln zu finden ist. Aber wenn ich ganz simpel 5774 / 24mm (der Höhe des 50-MP-KB-Sensors sowohl in Pixel als auch in mm)=240 Linien/mm : 2 rechne, komme ich nicht auf max. 85 lp/mm sondern auf 120 lp/mm, wenn wirklich jeder Pixel mit je einem Lichtpunkt versorgt wird.

- Zum Vergleich hier noch einmal der andere Weg in kompletter Form, der im Ergebnis auf max. 85 lp/mm des 50 MP-Sensors kommt: Die Auflösung bei 50 MP bei einem Seitenverhältnis von 3:2 ergibt 8660x5774 Pixel.1 Bei einer Sensorgröße in Pixeln X-Richtung von 8660 und den Sensormaßen von 36mm x 24mm des KB-Sensors ergibt sich eine Pixelgröße von 4,16 µm im Quadrat.2 (untere Eingabemaske) Daraus ergeben sich 500 / (4,16 µm * 1.41) = 85 lp/mm.3 (hier wie besprochen die Berechnung für Monochromsensoren)

- Wo liegt nun der Fehler? --

η eonZERO 11:27, 12. Jan. 2020 (CET)

- Wo liegt nun der Fehler? --

- Die 3,8 µm kommen bei meiner Rechnung mit 61 Megapixel und Vollformatsensor auch heraus, allerdings resultieren daraus 132 Linienpaare pro Millimeter (beziehungsweise 3158 Linienpaare pro Bildhöhe):

- Bezahlbare Objektive (damit meine ich maximal vierstellige Eurobeträge) werden solche Auflösungen auch auf der optischen Achse (für sogenannte paraxiale Strahlen) nicht leisten, jedenfalls nicht mit nennenswerten Kontrasten.

- Wird die Blendenzahl kleiner, verstärkt sich unweigerlich der Öffnungsfehler des Objektivs und somit sinkt die optische Auflösung. Wird die Blendenzahl größer, verstärkt sich unweigerlich die Beugungsbegrenzung der optischen Abbildung und somit sinkt die optische Auflösung. Für weitere Recherchen siehe auch kritische Blende.

- Ein brauchbares Objektiv liefert bei 1000 Linienpaaren pro Bildhöhe (bei einem Vollformatsensor mit 24 Millimetern Bildhöhe also bei 41,7 Linienpaaren pro Millimeter oder bei einer Smartphone-Kamera mit 4,2 Millimetern Bildhöhe also bei 238 Linienpaaren pro Millimeter) 100 Prozent Kontrast. Wenn ein hochwertiges Objektiv bei 2000 Linienpaaren pro Bildhöhe (beim Vollformatsensor also bei 83,3 Linienpaaren pro Millimeter oder bei der Smartphone-Kamera bei 476 Linienpaaren pro Millimeter) dann eventuell noch 50 Prozent Kontrast liefern kann, sind die entsprechenden Strukturen schon recht flau, und das sollte daher nicht überbewertet werden. Bei 3000 Linienpaaren pro Bildhöhe (beim Vollformatsensor also bei 250 Linienpaaren pro Millimeter) ist der Kontrast der optischen Abbildung praktisch null und ein solches Auflösungsvermögen eines Bildsensors sollte aus meiner Sicht daher besser gar nicht bewertet werden. --Bautsch 12:37, 13. Jan. 2020 (CET)

- Die 3,8 µm kommen bei meiner Rechnung mit 61 Megapixel und Vollformatsensor auch heraus, allerdings resultieren daraus 132 Linienpaare pro Millimeter (beziehungsweise 3158 Linienpaare pro Bildhöhe):

- Hast Du Dich da verrechnet? Die von Dir verwendete Formel ist auch im optowiki zu finden, jedoch werden laut der Quelle damit die Linien und nicht die Linienpaare pro Millimeter berechnet. Für Linienpaare werden gemäß dieser Quelle die 1000 durch 2 geteilt; also kann man auch gleich 500 schreiben. Das wäre dann:

- Farbe, beziehungsweise s/w (wie beim Siemensstern)

- In Deiner Rechnung verwendest Du den Faktor 2 für Farbsensoren; ich will hier jedoch auf das maximal Mögliche hinaus, also auf den Wert, der in keiner Messung hätte überschritten werden können. Und nach dem was Du geschrieben hast, kämen wir auf die Werte des Monochromsensors (Faktor 1,41), natürlich nur unter den von Dir weiter oben genannten Bedingungen, von denen wir in diesem Beispiel ausgehen. Gruß, --

η eonZERO 17:06, 13. Jan. 2020 (CET)

- In Deiner Rechnung verwendest Du den Faktor 2 für Farbsensoren; ich will hier jedoch auf das maximal Mögliche hinaus, also auf den Wert, der in keiner Messung hätte überschritten werden können. Und nach dem was Du geschrieben hast, kämen wir auf die Werte des Monochromsensors (Faktor 1,41), natürlich nur unter den von Dir weiter oben genannten Bedingungen, von denen wir in diesem Beispiel ausgehen. Gruß, --

- Ich hatte den Divisor zwei für die Paarbildung bei den Linien eingesetzt und nicht für den Bayer-Sensor, um die maximale Ortsfrequenz auszurechnen, bei der unter optimalen Umständen (also schwarzweiße Vorlage und korrigiertes Objektiv) noch Kontrast gemessen werden kann. Bei farbigen Motiven ist die Auflösung entsprechend der Faustfomel um den Faktor zwei kleiner, liegt also bei rund 66 Linienpaare pro Millimeter. --Bautsch 17:20, 13. Jan. 2020 (CET)

- Was bedeutet das jetzt? Ist die Formel aus dem optowiki falsch bezogen auf deren Angaben zu Monochromsensoren? Denn Monochromsensoren erfassen je Sensorpixel einen Lichtpunkt, ohne Auflösungsverluste durch Demosaicing oder andere Verfahren. Zumindest wenn ich die Beschreibung in Deinem Buch richtig verstanden habe. Es sollte dann keinen Unterschied geben zwischen der maximalen Ortsfrequenz und der maximalen Auflösung, die der Sensor zu erfassen vermag. Das ist die Grundlage meiner Überlegung die dazu führt, dass ich unter den von Dir weiter oben genannten Bedingungen den Farbsensor in der Berechung gleich setze mit dem Monochromsensor. --

η eonZERO 17:41, 13. Jan. 2020 (CET)

- Was bedeutet das jetzt? Ist die Formel aus dem optowiki falsch bezogen auf deren Angaben zu Monochromsensoren? Denn Monochromsensoren erfassen je Sensorpixel einen Lichtpunkt, ohne Auflösungsverluste durch Demosaicing oder andere Verfahren. Zumindest wenn ich die Beschreibung in Deinem Buch richtig verstanden habe. Es sollte dann keinen Unterschied geben zwischen der maximalen Ortsfrequenz und der maximalen Auflösung, die der Sensor zu erfassen vermag. Das ist die Grundlage meiner Überlegung die dazu führt, dass ich unter den von Dir weiter oben genannten Bedingungen den Farbsensor in der Berechung gleich setze mit dem Monochromsensor. --

- Querrechnung: Ein 61 Megapixel-Sensor mit 6320 Pixel in der Höhe und einer Abmessung im Kleinbildformat von 24mm in der Höhe enthält 6320 / 24 = 263,3 Linien pro Millimeter, was geteilt durch 2 = 131,6 Linienpaare pro Millimeter ergibt. Das entspricht Deiner Berechung der Ortsfrequenz von oben. Das war klar, denn Deine Formel ist leicht nachvollziehbar und absolut schlüssig. Ganz entgegen der Formel aus dem Optowiki, aus der ich mir weder den Faktor 2 für Farbsensoren herleiten konnte (das kann ich jetzt dank Deiner Erklärung) noch den Faktor 1,41 bei Monochromsensoren. D.h. herleiten läßt sich der Faktor 1,41 durch deren Beschreibung zwar, aber ich verstehe das nicht, Zitat "Für monochrome Anwendungen multipliziert man die Pixelgrösse mit 1.41 (=Wurzel aus 2) und erhält so die Diagonale des Pixels". Ich bin einfach gestrickt und meine ganz simple logische Betrachtung sagt mir, dass ich für die Berechnung der Linien die Höhe des quadratischen Sensorpixels, aber nicht seine Diagonale benötige. *grübel*

- Wir sind dem Ziel, meine eingangs gestellte Frage zu beantworten, jetzt sehr nahe. Dank Deiner obigen Beschreibung weiß ich nun, unter welchen Bedingungen ein Bayer-Farbsensor die Auflösung eines Monochromsensors (oder sogar noch mehr?) erreicht. Wenn wir noch klären können, wie die Diskrepanz zwischen der Ortsfrequenz und der laut Optowiki tatsächlichen Auflösung eines Monochromsensors entsteht und warum der Bayer-Farbsensor davon nicht betroffen ist, dann haben wir das Ziel erreicht. Gruß, --

η eonZERO 09:34, 14. Jan. 2020 (CET)

- Wir sind dem Ziel, meine eingangs gestellte Frage zu beantworten, jetzt sehr nahe. Dank Deiner obigen Beschreibung weiß ich nun, unter welchen Bedingungen ein Bayer-Farbsensor die Auflösung eines Monochromsensors (oder sogar noch mehr?) erreicht. Wenn wir noch klären können, wie die Diskrepanz zwischen der Ortsfrequenz und der laut Optowiki tatsächlichen Auflösung eines Monochromsensors entsteht und warum der Bayer-Farbsensor davon nicht betroffen ist, dann haben wir das Ziel erreicht. Gruß, --

- Zu dem Faktor Wurzel(2) = 1,41... kann ich nichts sagen, außer dass bei einem Quadrat die Diagonale nach dem Satz des Pythagoras um diesen Faktor länger ist als die Seitenkanten. Ich könnte mir nur vorstellen, dass dieser Faktor eingesetzt wird, um die maximale Ortsfrequenz auf der 45°-Diagonalen zu bestimmen, wüsste jedoch nicht, wie uns das hier weiterbringen sollte. Ich vermute, dass dieser Faktor 1,41... als "Kompromiss" oder empirischer Erfahrungswert zwischen dem allgemeinen Faktor 2 der von mir (und optowiki) genannten Faustformel und dem Faktor 1 bei schwarz-weißen Vorlagen liegt, wo auch mit Bayer-Sensoren die volle, bei monochromen Bildsensoren mögliche optische Auflösung erreicht werden kann. Das hätte dann allerdings nichts mit der Pixeldiagonale zu tun. --Bautsch 13:36, 14. Jan. 2020 (CET)

- Im Optowiki steht explizit etwas von "Pixeldiagonale", also wird auch das gemeint sein. Es ist gut möglich, das denen ein Fehler unterlaufen ist und sie aus versehen die Berechnungsformel für die 45°-Diagonale in ihre Wissensdatenbank überführt haben. Den von Dir als Alternative angesprochenen empirischen Erfahrungswert, der das wahre Auflösungsvermögen entsprechender Sensoren aufzeigt, kann es doch nur für Farbsensoren geben; bei Monochromsensoren gibt es schließlich keinen technischen Grund für eine Auflösungsminderung (oder?).

- Zitat "Faktor 1 [...] die volle, bei monochromen Bildsensoren mögliche optische Auflösung". Ich frage nur noch einmal nach, um wirklich jedes Missverständnis zu vermeiden: Faktor 1 bedeutet doch, dass die Auflösung eines monochromen Sensors identisch ist mit der maximalen Ortsfrequenz. Daraus ergibt sich, dass die Formeln zur Berechnung der Sensorauflösung wie folgt lauten:

- Für Monochromsensoren:

- Für Bayer-Farbsensoren:

- Zitat "Faktor 1 [...] die volle, bei monochromen Bildsensoren mögliche optische Auflösung". Ich frage nur noch einmal nach, um wirklich jedes Missverständnis zu vermeiden: Faktor 1 bedeutet doch, dass die Auflösung eines monochromen Sensors identisch ist mit der maximalen Ortsfrequenz. Daraus ergibt sich, dass die Formeln zur Berechnung der Sensorauflösung wie folgt lauten:

- Das entspricht (Kurzschreibweise im Stil vom Optowiki):

- Für Monochromsensoren: Linienpaare_pro_mm = 500 / Pixelgrösse

- Für Bayer-Farbsensoren: Linienpaare_pro_mm = 500 / (Pixelgrösse * 2) (sobald nicht die Bedingungen von oben zutreffen - dann wäre auch bei einem Farbsensor die Formel für Monochromsensoren zutreffend)

- Das entspricht (Kurzschreibweise im Stil vom Optowiki):

- Richtig? Gruß, --

η eonZERO 19:10, 14. Jan. 2020 (CET)

- Richtig? Gruß, --

- Keine Ahnung, was in dem OptoWiki mit "monochrome Anwendung" gemeint ist. Ich hatte es so verstanden, dass damit gemeint ist, dass schwarz-weiße Vorlagen mit einem Bayer-Sensor aufgenommen werden. Wie auch immer, die beiden Formeln sind aus meiner Sicht korrekt, und die maximal erreichbare Auflösung von monochromen und insbesondere schwarzweißen Vorlagen mit einem Bayer-Sensor liegt irgendwo zwischen diesen beiden Ortsfrequenzen. --Bautsch 13:14, 15. Jan. 2020 (CET)

- Ich hatte das bislang so verstanden, dass das OptoWiki damit zwischen Monochrom- und Farbsensoren unterscheidet. Auf Deine Idee mit der schwarz-weißen Vorlage bin ich leider nicht selbst gekommen, aber sie klingt interessant, auch wenn sie damit kolossal daneben liegen würden. Wie oben bereits geschrieben kommt das Testlabor bei der Analyse eines Fotos, das mit einem 50 MP großen KB-Sensor aufgenommen wurde, auf 102 lp/mm. Die maximale Ortsfrequenz liegt bei 120 lp/mm, was gut dazu passt. Das Testergebnis muss ja kleiner bis gleich hoch sein. Nach der Formel des OptoWikis käme man für "monochrome Anwendungen" mit ihrem Faktor 1,41 auf max. 85 lp/mm, die ein 50 MP KB Sensor erfassen kann. Diese Formal kann also nicht stimmen, egal ob sie für Monochromsensoren oder für "Byer-Farbsensoren in monochromer Anwendung" gedacht war. Es spielt auch keine Rolle ob sie mit "monochromer Anwendung" womöglich etwas vollkommen anderes meinen, denn diese Formel bleibt damit noch immer nicht für die hier behandelten Fälle anwendbar. Gruß, --

η eonZERO 21:37, 15. Jan. 2020 (CET)

- Ich hatte das bislang so verstanden, dass das OptoWiki damit zwischen Monochrom- und Farbsensoren unterscheidet. Auf Deine Idee mit der schwarz-weißen Vorlage bin ich leider nicht selbst gekommen, aber sie klingt interessant, auch wenn sie damit kolossal daneben liegen würden. Wie oben bereits geschrieben kommt das Testlabor bei der Analyse eines Fotos, das mit einem 50 MP großen KB-Sensor aufgenommen wurde, auf 102 lp/mm. Die maximale Ortsfrequenz liegt bei 120 lp/mm, was gut dazu passt. Das Testergebnis muss ja kleiner bis gleich hoch sein. Nach der Formel des OptoWikis käme man für "monochrome Anwendungen" mit ihrem Faktor 1,41 auf max. 85 lp/mm, die ein 50 MP KB Sensor erfassen kann. Diese Formal kann also nicht stimmen, egal ob sie für Monochromsensoren oder für "Byer-Farbsensoren in monochromer Anwendung" gedacht war. Es spielt auch keine Rolle ob sie mit "monochromer Anwendung" womöglich etwas vollkommen anderes meinen, denn diese Formel bleibt damit noch immer nicht für die hier behandelten Fälle anwendbar. Gruß, --

Blende und optische Auflösung vs effektive Bildauflösung in lp/mm

Es gibt ein weiteres Phänomen, das ich mir einfach nicht erklären kann: Ein Testlabor ermittelte an der 61 Megapixel auflösenden Sony Alpha 7R IV mit dem Objektiv Sony FE 24-105 mm F4 G OSS bei Blende F8 eine Auflösung von 90 lp/mm.1 Das Beugungsscheibchen hat bei F8 jedoch einen Durchmesser von 10,73 µm (=(2,44*550nm*F8) / 1000), woraus sich eine maximale optische Auflösung von 47 lp/mm ergibt (=500 / 10,73µm). Wie konnten sie unter diesen Bedingungen 90 lp/mm messen? --

- Die 5,4 Mikrometer Beugungsscheibchendurchmesser sorgen dafür, dass bei maximal 93 Linienpaaren pro Millimeter (bei schwarz-weißen Vorlagen halt auch mit einem Bayer-Sensor) noch ein sehr hoher Kontrast erreicht werden kann. Das heißt aber nicht, dass bei 101,6 Linienpaaren pro Millimeter kein Kontrast mehr vorhanden ist:

- Bei Beugungsauflösung mit hohem Kontrast (fast 90 Prozent Modulation) können zwei benachbarte Beugungsscheibchen gut von einander getrennt gesehen werden (obere Bildreihe). Bei einer Halbierung des Abstands (also bei doppelter Ortsfrequenz) ist die Modulation unter 1 Prozent, also praktisch nicht mehr wahrnehmbar. Je nachdem bei welcher Restmodulation die Schwelle festgelegt wird, ergeben sich also unterschiedliche maximale Ortsfrequenzen. Ich würde sagen, dass ein Modulation von 90 Prozent eine sehr gute Bildqualität hervorruft, und alles was darunter liegt ist entsprechend schlechter.

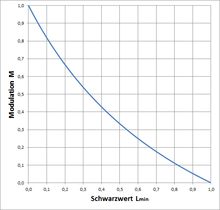

Die Modulation in Abhängigkeit vom Schwarzwert. Der Schwarzwert ist einheitenlos in Anteilen des Weißwertes angegeben. - Eine Modulation von 50 Prozent erzeugt ein als ziemlich flau empfundenes Bild, denn Schwarz hat dann nicht mehr die Leuchtdichte 0 (das wären 100 Prozent Kontrast), sondern ein Drittel der hellsten Leuchtdichte. --Bautsch 11:51, 16. Jan. 2020 (CET)

- Wie kommst du darauf, dass man 1% Helligkeitsunterschied nicht mehr wahrnehmen kann? Ich habe auf meinem PC festgestellt, dass ich deutlich weniger als 1% wahrnehmen kann (z.B. Graustufe 127 und 128). Die Nichtwahrnehmbrakeit kommt eher, daher, dass man meistens weiße Linien verwendet, also nahe Graustufe 255. Wenn man zwischen 2 Linien mit Graustufe 255 eine Linie mit Graustufe 253 hat, kann man tatsächlich keinen Unterschied mehr festlegen, wenn der Monitor richtig kalibriert ist (also so dass Graustufe 255 tatsächlich weiß ist und nicht hellgrau). --MrBurns (Diskussion) 16:18, 16. Jan. 2020 (CET)

- An Stufen mit plötzlicher Helligkeitsänderung (je nach tatsächlicher Leuchtdichte und Kalibrierung des Bildschirms, siehe übrigens auch Machsche Streifen) ist es möglich, solch geringe Helligkeitsunterschiede zu sehen, aber nicht zwischen den beiden Maxima und dem dazwischen liegenden Minimum bei der Überlagerung zweier Beugungsscheibchen in einem reellen Bild (siehe Beispiel oben). Solche reellen Bilder entstehen, wenn zum Beispiel ein Doppelstern mit zwei gleich hellen Sternen optisch abgebildet wird (geometrisch würden nur zwei Punkte im Bild zu sehen sein, tatsächlich sind es zwei Beugungsscheibchen). --Bautsch 17:17, 16. Jan. 2020 (CET)

- Wie kommst du darauf, dass man 1% Helligkeitsunterschied nicht mehr wahrnehmen kann? Ich habe auf meinem PC festgestellt, dass ich deutlich weniger als 1% wahrnehmen kann (z.B. Graustufe 127 und 128). Die Nichtwahrnehmbrakeit kommt eher, daher, dass man meistens weiße Linien verwendet, also nahe Graustufe 255. Wenn man zwischen 2 Linien mit Graustufe 255 eine Linie mit Graustufe 253 hat, kann man tatsächlich keinen Unterschied mehr festlegen, wenn der Monitor richtig kalibriert ist (also so dass Graustufe 255 tatsächlich weiß ist und nicht hellgrau). --MrBurns (Diskussion) 16:18, 16. Jan. 2020 (CET)

Ich verstehe. Das bedeutet, dass mit 5,4 µm Beugungsscheibchendurchmesser (zu erreichen bei Blende F4) dank des hohen Kontrasts gut 93 lp/mm erfaßt werden können. Bei einer Erhöhung des Blendenwerts erhöht sich die Größe und damit der Abstand der Lichtpunkte zueinander. Sie sind nun schwerer von einander unterscheidbar und die erfaßbare Auflösung sinkt. Mit der Eingangs angesprochenden Blende F8 erhält das Beugungsscheibchen einen Durchmesser von 10,8 µm, wodurch sich der Abstand halbiert den die Lichtpunkte zueinander einnehmen; die optische Auflösung sinkt auf die doppelter Ortsfrequenz (anders formuliert halbiert sich die optische Auflösug im Vergleich zu F4 von 93 lp/mm auf knapp 47 lp/mm).

Was ich nicht verstehe ist, dass sich dies nicht im Messergebnis widerspiegelt. So müßten die erfaßten und damit messbaren Details sinken, der Grauring im Siemensstern im Durchmesser deutlich zunehmen, das Messergebnis deutlich auf die Auflösungsminderung hinweisen. Schließlich soll die Messung die erfaßte Auflösung ermitteln. Wie konnte das eingangs genannte Testlabor also aus einem Foto, das bei Blende F8 aufgenommen wurde, eine Auflösung von 90 lp/mm ermitteln, wenn dem Kamerasystem optisch nur 47 lp/mm zur Verfügung standen? Gruß, --

- Genau genommen verändert sich der strahlengeometrische Abstand der Mittelpunkte der Beugungsscheibchen bei größeren Blendenzahlen nicht, sondern deren Durchmesser wird größer, und dadurch die Überlappung stärker und der Kontrast niedriger. Bei der Blendenzahl 8 und einem Vollformatsensor beginnt ab 1100 Linienpaaren pro Bildhöhe (oder 46 Linienpaaren pro Millimeter) die Beugungsbegrenzung. Das heißt das immer feinere Strukturen deswegen mit zunehmend geringerem Kontrast abgebildet werden (zusätzliche Verringerung durch die (bei großen Ortsfrequenzen sehr wahrscheinlichen) Objektivfehler insbesondere in den Bildecken natürlich nicht ausgeschlossen). Dies bedeutet einen Verlust an Bildqualität allein durch die Beugungsbegrenzung der Objektivblende und nicht durch den Bildsensor. Dieser Effekt ist in den Rohdatenaufnahmen meistens deutlicher nachzuvollziehen als in den vom Kameragehäuse "entwickelten" JPEG-Dateien, da die (äußerst leistungsfähigen) Bildprozessoren eine Menge Bilddatenverarbeitung durchführen, wie zum Beispiel Anti-Aliasing, Rauschunterdrückung, Weißabgleich und eine ortsfrequenzabhängige Erhöhung des Kontrastes. Wenn bei sehr hohen Ortsfrequenzen der Kontrast künstlich zu stark erhöht wird oder durch Pixelfehler (siehe auch Hotpixel) sowie das Aliasing Artefakte scheinbar hervorgerufen wird, kann sogar ein Bildkontrast ermittelt (und gegebenenfalls bewertet) werden, der der Bildqualität gar nicht zuträglich ist. --Bautsch 10:33, 17. Jan. 2020 (CET)

- Zitat: "deren Durchmesser wird größer, und dadurch die Überlappung stärker" - genau das meinte ich damit, habe es nur unglücklich formuliert.

- Du meinst mit Deiner Ausführung also, dass über die 46 lp/mm hinaus durchaus Bildinformationen erfaßt werden können, jedoch mit zunehmendem Verlust an Bildqualität, wie Kontrastverlust, etc; zusammengenommen gehen bei F8 über die 46 lp/mm hinaus mehr und mehr Details verloren. Das erklärt warum der Grauring beim Siemensstern nicht schlagartig, sondern mit einem "weichen Übergang" in Erscheinung tritt. Allerdings titt er in Erscheindung, was bedeutet, dass der bei Blende F8 im Vergleich zur Blende F4 früher einsetzende Detailverlust messbar sein sollte.

- Wenn ich Dich richtig verstanden habe, dann schreibst Du dass der Detailverlust im Testlabor erst bei mehr als 90 lp/mm gemessen werden konnte, weil die Auswirkungen der Beugung aus den Bild bereits in der Kamera herausgerechnet wurde. Das ein moderner Bildverarbeitungsprozessor aus den Informationen, die über die 46 lp/mm hinaus vom Sensor erfaßt werden, eine solch hohe Bildauflösung errechnen kann, hätte ich nicht für möglich gehalten. Das Messergebnis ist schließlich doppelt so hoch, als es die Optik eigentlich her gibt. Wow. Gruß, --

η eonZERO 14:02, 17. Jan. 2020 (CET)

- Wenn ich Dich richtig verstanden habe, dann schreibst Du dass der Detailverlust im Testlabor erst bei mehr als 90 lp/mm gemessen werden konnte, weil die Auswirkungen der Beugung aus den Bild bereits in der Kamera herausgerechnet wurde. Das ein moderner Bildverarbeitungsprozessor aus den Informationen, die über die 46 lp/mm hinaus vom Sensor erfaßt werden, eine solch hohe Bildauflösung errechnen kann, hätte ich nicht für möglich gehalten. Das Messergebnis ist schließlich doppelt so hoch, als es die Optik eigentlich her gibt. Wow. Gruß, --

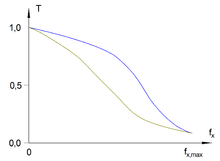

Vergleich der Modulationsübertragungsfunktionen von zwei verschiedenen Objektiven mit demselben Bildsensor. Bei der Ortsfrequenz null haben alle Objektive die maximale Kontrastübertragung von eins, und bei der maximal dargestellten Ortsfrequenz haben beide hier dargestellten Objektive eine Kontrastübertragung von zirka zehn Prozent. Dennoch ist das blau dargestellte Objektiv deutlich besser als das dunkelgelb dargestellte, da es mittlere Ortsfrequenzen besser überträgt. - Ganz so euphorisch würde ich das nicht sehen: bei dem, was "die Optik hergibt" (sprich ohne Beugungsbegrenzung) werden im Idealfall über 90 Prozent Kontrast gemessen, die Messergebnisse bei größeren Ortsfrequenzen ergeben zunehmend weniger Kontrast. Die eigentliche Frage ist, welche Kontraste bei welchen Ortsfrequenzen werden wie bewertet, um eine Bildqualität zu ermitteln. Und wer hierbei nach weniger nutzwertigen, aber möglichst hohen Zahlen giert, ist aus meiner Sicht schlechter beraten, als jemand der einfach nur die nützlichen Ortsfrequenzbereiche und deren Modulationübertragungen bewertet. Erstere könnten statt einer Messung im Prinzip auch einfach nur die Pixel auf dem Bildsensor zählen (oder deren Anzahl ausrechnen), letztere messen die tatsächliche Kontrastübertragung bei allen Ortsfrequenzen und bewerten die wichtigen. --Bautsch 13:50, 18. Jan. 2020 (CET)

- Zitat: "bei dem, was "die Optik hergibt" (sprich ohne Beugungsbegrenzung) werden im Idealfall über 90 Prozent Kontrast gemessen". Ich lese mir den Testbericht gerade noch einmal durch und die schreiben dort, Zitat "Die höchste Auflösung erreicht die Sony [...] bei 50 Prozent Kontrast mit [...] 101,6 lp/mm bei F4 [...]".1 Leider schreiben sie an der Stelle, an der die Auflösung von 90 lp/mm bei F8 erwähnt wird, nichts von dem Kontrast, aber ich gehe jetzt einmal davon aus, dass auch dort die 50% gemeint sind. Bedeutet das jetzt, dass das Testlabor bei Ihrer Messung einfach nur den Schwellwert runter setzte, indem sie statt der 90% eine 50%-Kontrastvorgabe nutzen, und das nur, um im Ergebnis mehr lp/mm zu erhalten? Gruß, --

η eonZERO 18:11, 20. Jan. 2020 (CET)

- Zitat: "bei dem, was "die Optik hergibt" (sprich ohne Beugungsbegrenzung) werden im Idealfall über 90 Prozent Kontrast gemessen". Ich lese mir den Testbericht gerade noch einmal durch und die schreiben dort, Zitat "Die höchste Auflösung erreicht die Sony [...] bei 50 Prozent Kontrast mit [...] 101,6 lp/mm bei F4 [...]".1 Leider schreiben sie an der Stelle, an der die Auflösung von 90 lp/mm bei F8 erwähnt wird, nichts von dem Kontrast, aber ich gehe jetzt einmal davon aus, dass auch dort die 50% gemeint sind. Bedeutet das jetzt, dass das Testlabor bei Ihrer Messung einfach nur den Schwellwert runter setzte, indem sie statt der 90% eine 50%-Kontrastvorgabe nutzen, und das nur, um im Ergebnis mehr lp/mm zu erhalten? Gruß, --