視覚 と自然 言語 の融合 研究

1960

背景

[コンピュータビジョン

[コンピュータビジョンは、コンピュータに

自然 言語 処理

[主 な研究 分野

[自然 言語 処理 のタスクの拡張

[

画像 ・動画 の説明 生成 画像 や動画 に対 する説明 を生成 するタスクである[38][注釈 3]。この融合 分野 の代表 的 なタスクとされる[39]画像 キャプション生成 も含 まれる[40]。画像 キャプション生成 の研究 は2000年代 から行 われており[19]、検索 エンジンやソーシャルメディアなどで画像 の説明 を生成 するために利用 されている[41]。

画像 ・動画 への質問 応答 (Visual Question Answering、VQA)自然 言語 処理 における質問 応答 は、人間 の質問 に対 して回答 するタスクである[42]。質問 応答 では、質問 に回答 するにあたって必要 な情報 を得 るために、なんらかの文書 を参照 する場合 もある[43]。質問 応答 が自然 言語 のみを使用 するのに対 して、VQAは質問 応答 タスクを拡張 した、画像 や動画 に関 する質問 に答 えるタスクである[38]。未知 の物体 にも対応 するようなVQAは2014年 に研究 が始 められた[44]。

画像 検索 (Image Retrieval)多数 の画像 の中 から、画像 を検索 するタスクである[45]。キーワードや文章 などの自然 言語 をクエリとして使用 するタスク、画像 をクエリとして類似 している画像 を検索 するタスク、手書 きの絵 をクエリとするタスクなどが研究 されている[46][47]。従来 は画像 に人間 がつけたキャプションなどを利用 して検索 を行 っていたが、1990年代 から画像 に含 まれる視覚 情報 も用 いて検索 を行 う研究 が行 われるようになった[48][45]。検索 エンジンでも使用 されている[49][50]。

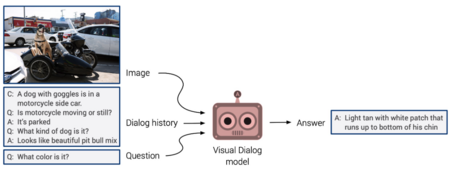

画像 ・動画 に関 する対話 (Visual Dialog)画像 や動画 に含 まれる情報 に対 して、自然 言語 を用 いて対話 を行 うタスクである[38]。例 えば、人間 が対話 システムに画像 の内容 に関 する複数 の質問 を問 いかけるという対話 において、対話 システムは過去 の対話 内容 も考慮 して回答 する必要 がある[51]。- Visual Dialogは2017

年 に提案 されて研究 が始 まった[52]。

画像 の参照 表現 (Visual Referring Expression)の理解 ・生成 参照 表現 (Referring Expression)とは「左 の三 つの玉 のうちの一番 右 の玉 」のように複数 の物体 の中 から特定 の物体 を識別 するための言語 表現 である[53]。視覚 との融合 分野 では、自然 言語 で与 えられた参照 表現 に対応 する物体 を画像 中 で示 したり、画像 中 の物体 に対応 する参照 表現 を生成 するタスクが研究 されている[54]。参照 表現 生成 の研究 は自然 言語 処理 の分野 で1970年代 から行 われているが[55]、2010年代 まで画像 などに含 まれる視覚 情報 を直接 使 うような手法 はほとんど研究 されていなかった[56][57]。深層 学習 を用 いた画像 の参照 表現 の理解 と生成 の最初 の研究 は2016年 に発表 され[58]、画像 から直接 の参照 表現 の理解 ・生成 を行 う研究 が始 まった[57]。

画像 の含意 関係 認識 (Visual Entailment)自然 言語 処理 において、含意 関係 認識 という「ある文章 が正 しければもう一方 の文章 も正 しいと言 えるか」を判別 するタスクがある[38]。例 えば「川端 康成 は「雪国 」などの作品 でノーベル文学 賞 を受賞 した」という文章 が正 しいときは「川端 康成 は「雪国 」の作者 である」も正 しいという関係 を判別 することが求 められる[59]。視覚 との融合 分野 では、画像 に示 された状況 が正 しいときに与 えられた文章 が正 しいと言 えるかを判別 するタスクが提案 されている[38]。- 2018

年 にVisual Entailmentのタスクを提案 する研究 が発表 された[60]。

コンピュータビジョンのタスクの拡張

[文章 に対 する画像 生成 与 えられた文章 に対応 した画像 を生成 するタスクである[38][注釈 4]。敵対 的 生成 ネットワーク(GAN)の登場 に伴 い、2016年 に文章 から画像 を生成 する最初 の研究 が発表 された[65]。

- Visual Reasoning

画像 分類 や物体 検出 を拡張 したタスクであり[38]、画像 や動画 に含 まれる視覚 情報 を理解 するタスクである[66]。一 例 として、画像 に含 まれる複数 の物体 同士 の関係 性 などを理解 するタスクなどが含 まれる[67][68]。Visual Reasoningは視覚 情報 に対 する質問 に回答 するための過程 として定義 されることもある[69]。すなわち、VQAやVisual Dialogのモデルは(明示 的 に設計 されていなくても)Visual Reasoningを行 なっていることになる[69]。Visual Reasoningの手法 を評価 するために、VQAを用 いることも一般 的 である[68]。初期 の研究 は1960年代 から行 われている[67]。

自然 言語 処理 とコンピュータビジョンのタスクの拡張

[

視覚 と言語 を用 いたナビゲーション- ナビゲーションはロボットなどに

対 して目的 地 までの道順 を案内 するタスクであり[70]、視覚 情報 もしくは自然 言語 のみでのナビゲーションが研究 されてきた[38]。これらを拡張 して、視覚 と自然 言語 の両方 の情報 を使用 するタスクが融合 分野 として研究 されている[38]。 視覚 と自然 言語 の両方 の情報 を用 いるナビゲーションとしては、最初 のデータセットが2017年 に発表 されている[71]。

歴史

[黎明 期 (1960年代 以降 )

[1968

深層 学習 以前 (1990年代 〜2000年代 )

[深層 学習 の適用 (2010年代 以降 )

[2010

手法

[

視覚 情報 と自然 言語 情報 の統合 (2018年 ごろまでの主流 )

[これらの

統合 的 な事前 学習 (2019年 以降 )

[主 なタスクの研究 ・評価 手法

[画像 ・動画 の説明 生成

[画像 キャプション生成 の手法 研究 が始 められた2000年代 ごろには主 にテンプレートを用 いた手法 が提案 されていた[19]。テンプレートを用 いて文章 を生成 するためにSIFTやHOGなどの局所 画像 特徴 量 [73]に対 してSVMなどの分類 器 を適用 するなどの手法 が提案 された[74][75]。深層 学習 を用 いた手法 が発展 した2010年代 には、CNNとRNNを用 いる方法 が一般 的 になった[75]。さまざまなモデルが提案 されているが、単純 かつ一般 的 に使用 されている手法 としては教師 あり学習 を用 いたエンコーダ・デコーダモデルがある[88]。これは、CNNを用 いて画像 特徴 量 を抽出 して、画像 特徴 量 をRNNに入力 してキャプションを生成 するという手法 である[89]。2019年 には画像 と自然 言語 の両方 にTransformerを使用 する手法 も提案 されている[90]。

評価 手法 主 に使用 されているのは、生成 された説明 とデータセットに含 まれる説明 の類似 度 による評価 である[91][92]。BLEU、ROUGE、METEORといった機械 翻訳 などの自然 言語 処理 タスクで使用 されている評価 基準 が使 われている[91][92]。

画像 ・動画 への質問 応答 (VQA)

[

手法 - 2014

年 に研究 が始 められた当初 の手法 は、あらかじめ定義 された形式 の回答 に限定 されたものだったが、2015年 には回答 の形式 を限定 しないような質問 にも対応 できるモデルが提案 された[94]。2015年 に提案 されたモデルのひとつは、CNNで抽出 された画像 の特徴 量 ベクトルと質問 文章 の単語 ベクトルの両方 をエンコーダのRNN(LSTM)に入力 することで特徴 量 を統合 し、デコーダのRNNで回答 を生成 する手法 である[95]。同 時期 には、特徴 量 の統合 の方法 を変更 したり、注意 機構 (Attention)の適用 や、データベースを利用 する方法 など、様々 な手法 が提案 されている[95]。2019年 には自然 言語 処理 にTransformerを使用 するモデルや[96]、Transformerを用 いて画像 と自然 言語 の特徴 量 を統合 的 に事前 学習 する手法 が提案 されている[97]。

評価 手法 - VQAの

回答 は画像 キャプションなどよりは短 いことが多 いため、単純 な評価 手法 が使用 されることが多 いが、高度 な評価 手法 も研究 されている[98]。単純 な手法 のひとつは、生成 された回答 とデータセットに含 まれる回答 が厳密 に一致 しているかを評価 することである[99]。高度 な手法 としては、回答 の意味 の類似 度 を評価 する手法 が研究 されている[99]。

画像 検索 (Image Retrieval)

[

手法 - さまざまな

種類 のクエリに対 する画像 検索 が研究 されているが[46][47]、文章 か画像 をクエリとする研究 が多 く研究 されている[100]。 文章 をクエリとする検索 について、2019年 でもウェブ検索 では人間 がつけたキャプションなどの自然 言語 の情報 を利用 しているとされている[100]。キャプションがない画像 も検索 するために、画像 キャプション生成 などを用 いて[41]自動的 にアノテーションを行 う手法 を適用 することが研究 されている[101]。人間 がつけたキャプションなどを利用 しない方法 として、1990年代 から画像 をクエリとして類似 する画像 を検索 する研究 が行 なわれている[101][102]。画像 をクエリとした画像 検索 は、画像 から特徴 量 を抽出 して類似 度 を評価 することで行 なわれる[103]。初期 の研究 として色 、形 、質感 などを特徴 量 として使用 する方法 が研究 されてきたが、それだけでは画像 が表 す意味 の類似 性 を比較 することができないことが課題 だった[102]。そのため、深層 学習 が適用 される以前 から、画像 全体 の意味 も表 すような特徴 量 も併用 する試 みが研究 されてきた[102]。深層 学習 を使用 した方法 も数多 く提案 されており、CNNを利用 して画像 検索 に有用 な特徴 量 を抽出 する研究 が行 なわれている[104]。

評価 手法 画像 検索 には情報 検索 の評価 手法 が用 いられる[105]。評価 手法 として様々 なものがあり、想定 される適用 先 などによって使 い分 けることが求 められる[106]。広 く用 いられているのは適合 率 (Precision)と再現 率 (Recall)、およびF値 である[106]。ここで、検索 結果 の上位 k個 の画像 を「検出 された」と判定 するとする[106]。また、評価 の際 には、検出 されるべき正解 の画像 (複数 の場合 もある)が分 かっているとする[106]。下 式 のように、適合 率 (P)は検出 された画像 の中 で、正解 の画像 (tp)の割合 で表 される(fpは誤 って検出 された画像 の数 )[106]。再現 率 (R)は検出 されるべき正解 の画像 の中 で、実際 に検出 された画像 (tp)の割合 で表 される(fnは正解 の画像 だが、検出 されなかった画像 の数 )[106]。- F

値 は適合 率 と再現 率 の調和 平均 で求 められる[106]。

文章 に対 する画像 生成

[手法 - 2016

年 からGANを応用 した手法 が提案 されていたが、文章 で条件付 けしない通常 の画像 生成 と比較 すると、生成 される画像 の質 が低 かった[65]。画像 の質 を高 めるために複数 のGANを使用 したり、文章 全体 の意味 を画像 に反映 するために注意 機構 (Attention)を使用 する研究 が提案 された[65]。

評価 手法 - GANなどのコンピュータビジョンにおける

画像 生成 タスクで使用 される評価 指標 が使 われている[107]。Inception Scoreという指標 を用 いて画像 の質 や多様 性 を評価 できるが、Inception Scoreでは文章 に対応 した画像 を生成 できているかを評価 することができないので、R-Precisionという指標 も併用 される[108]。

データセット

[さまざまなデータセットが

画像 ・動画 の説明 生成

[データセットには

キャプション付 き画像 データセット

[| SBU Captioned Photo Dataset | 2011 | 1,000,000 | 1 | Flickrから |

[113] |

| Flickr 30K Images | 2014 | 31,014 | 5 | Flickrから |

[114] |

| Microsoft COCO Dataset | 2014 | 123,287 | 5 | Flickrから |

[116] |

説明 付 き動画 データセット

[| Microsoft Research Video Description Corpus | 2011 | 1,970 | 5.3 |

70,028 | YouTubeの |

[117] |

画像 への質問 応答

[| Visual Question Answering Dataset (v1.0) | 2015 | 204,721 + 50,000 | 614,163 + 150,000 | 6,141,630 + 1,500,000 | MS COCOの |

[122] |

課題

[データセットバイアス

[データセットバイアスとは、

データセットバイアスはコンピュータビジョンや

評価 の難 しさ

[脚注

[注釈

[- ^

日本語 での表記 は複数 存在 し、「視覚 と自然 言語 の融合 研究 」[1]、「視覚 と言語 の融合 研究 」[2][3]、「画像 と自然 言語 処理 の融合 研究 」[4]、「CVとNLPの融合 研究 」[5]などの他 に"Vision and Language"と英語 のままで呼 ばれることもある[6][7]。 - ^ "Vision and Language"[8][9][10]の

他 に"Language and Vision"[11]など表記 に揺 らぎはある。 - ^

自然 言語 処理 分野 において、与 えられた文章 の次 の文章 を生成 する「条件 付 き言語 生成 」は広 く研究 されているが、これを拡張 した、与 えられた画像 や動画 に対 して「条件 付 き言語 生成 」をするというタスクとして捉 えることもできる[38]。 - ^ コンピュータビジョンで

画像 に対 する画像 の生成 (白黒 写真 からカラー写真 の生成 など[64])などが研究 されているが、これを自然 言語 との融合 分野 に拡張 したタスクとして捉 えることもできる[38]。 - ^

未知 の物体 なども対象 とした(open-world)手法 として初 めて提案 されたのがMalinowski et al. (2014)[10]である[44]。 - ^

自然 言語 処理 分野 においては、単語 ベクトルを事前 学習 することは広 く研究 されてきた[83]。 - ^ サーベイ

論文 [111][9]で挙 げられているデータセットを中心 に取 り上 げる。

出典

[- ^ a b c d

牛久 祥 孝 . “【記事 更新 】私 のブックマーク「視覚 と自然 言語 の融合 研究 (Integrating Vision and Language)」 –人工 知能 学会 (The Japanese Society for Artificial Intelligence)”.人工 知能 学会 . 2022年 3月 24日 閲覧 。 - ^ “NL

研 ・CVIM研 ・PRMU研 の合同 研究 会 :第 248回 自然 言語 処理 研究 会 発表 募集 ”.情報処理 学会 自然 言語 処理 研究 会 (NL) (2021年 2月 9日 ). 2022年 3月 24日 閲覧 。 - ^ “【

第 48回 AIセミナー】「マルチモーダル情報 の統合 理解 の最前線 」”.人工 知能 研究 センター. 2022年 3月 24日 閲覧 。 - ^ a b c “AI

白書 2017:IPA独立 行政 法人 情報処理 推進 機構 ”.情報処理 推進 機構 . p. 42. 2022年 3月 24日 閲覧 。 - ^ a b c

一般 社団 法人 情報処理 学会 . “第 247回 NL研究 発表 会 -情報処理 学会 ”. www.ipsj.or.jp. 2022年 3月 24日 閲覧 。 - ^

井尻 ,善久 ;牛久 ,祥 孝 ;片岡 ,裕雄 ;藤吉 ,弘 亘 , eds. (2021). コンピュータビジョン最前線 Winter 2021.共立 出版 . p. 78. - ^

品川 ,政 太朗 「Vision and Languageと分野 を取 り巻 く深層 学習 手法 の紹介 」『研究 報告 コンピュータビジョンとイメージメディア(CVIM)』2021-CVIM-226第 15号 、2021年 5月 13日 、1–1頁 、ISSN 2188-8701。 - ^ “Workshop on Vision and Language - ACL Anthology”. ACL Anthology. ACL. 2022

年 3月 24日 閲覧 。 - ^ a b Mogadala, Kalimuthu & Klakow 2021.

- ^ a b c Antol, Stanislaw; Agrawal, Aishwarya; Lu, Jiasen; Mitchell, Margaret; Batra, Dhruv; Lawrence Zitnick, C.; Parikh, Devi (2015). “VQA: Visual Question Answering”. Proceedings of the IEEE International Conference on Computer Vision (ICCV): 2425–2433.

- ^ “CVPR 2015 Language and Vision Workshop | The Center for Brains, Minds & Machines”. Center for Brain, Minds & Machines. 2022

年 3月 24日 閲覧 。 - ^ a b Mogadala, Kalimuthu & Klakow 2021, p. 1183.

- ^ a b Ferraro 2015, p. 210.

- ^ [1][4][13]

- ^ [1][10][13]

- ^ a b c d e f g h Ferraro 2015, p. 207.

- ^ a b c Terry Winograd. “SHRDLU”. 2022

年 3月 24日 閲覧 。 - ^ a b c Kafle 2019, 2.1. Tasks in V&L Research.

- ^ a b c d Wang 2021, p. 2.

- ^ a b c d e f g Kafle 2019, 1. Introduction.

- ^ a b c d e f g Kafle 2019, 3.1. Dataset Bias.

- ^ a b c d e f Kafle 2019, 3.2. Evaluation Metrics.

- ^ a b c d Mogadala, Kalimuthu & Klakow 2021, p. 1184.

- ^ a b Fern, Sonia. “The intersection of vision and language” (

英語 ). phys.org. 2022年 4月 9日 閲覧 。 - ^ Mogadala, Kalimuthu & Klakow 2021, pp. 1183–1184.

- ^ Sonka 2008, p. 1.

- ^ Huang, T (1996) (

英語 ). Computer Vision: Evolution And Promise. doi:10.5170/CERN-1996-008.21. - ^ “コンピューター ビジョンとは | Microsoft Azure”. Microsoft. 2022

年 4月 8日 閲覧 。 - ^ a b Mogadala, Kalimuthu & Klakow 2021, p. 1185.

- ^ Sonka 2008, p. 385.

- ^ Cao, Yang-Jie; Jia, Li-Li; Chen, Yong-Xia; Lin, Nan; Yang, Cong; Zhang, Bo; Liu, Zhi; Li, Xue-Xiang et al. (2019). “Recent Advances of Generative Adversarial Networks in Computer Vision”. IEEE Access 7: 14985–15006. doi:10.1109/ACCESS.2018.2886814. ISSN 2169-3536.

- ^ Wang, Zhengwei; She, Qi; Ward, Tomás E. (2022-03-31). “Generative Adversarial Networks in Computer Vision: A Survey and Taxonomy” (

英語 ). ACM Computing Surveys 54 (2): 1–38. doi:10.1145/3439723. ISSN 0360-0300. - ^ a b c Jurafsky 2009, p. 1.

- ^ Eisenstein 2019, p. 1.

- ^ Jurafsky 2009, p. 737.

- ^ a b Eisenstein 2019, p. 424.

- ^ Eisenstein 2019, p. 431.

- ^ a b c d e f g h i j k l m n Mogadala, Kalimuthu & Klakow 2021, p. 1187.

- ^ Baltrušaitis 2019, p. 424.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1190.

- ^ a b Hossain 2019, p. 1.

- ^ Jurafsky 2009, p. 779.

- ^ Jurafsky 2009, p. 780.

- ^ a b Wu 2017, p. 3.

- ^ a b c Mezaris, V.; Kompatsiaris, I.; Strintzis, M.G. (2003-09). “An ontology approach to object-based image retrieval”. Proceedings 2003 International Conference on Image Processing (Cat. No.03CH37429) 2: II–511. doi:10.1109/ICIP.2003.1246729.

- ^ a b Datta 2008, pp. 11–12.

- ^ a b Latif 2019, p. 3.

- ^ Datta 2008, p. 4.

- ^ Kaput, Mike. “AI in Search Engines: Everything You Need to Know” (

英語 ). Marketing AI Institute. 2022年 4月 9日 閲覧 。 - ^ “Google Search By Image: Use A Snapshot As Your Search Query” (

英語 ). TechCrunch. 2022年 4月 9日 閲覧 。 - ^ Mogadala, Kalimuthu & Klakow 2021, p. 1246.

- ^ a b Das, Abhishek; Kottur, Satwik; Gupta, Khushi; Singh, Avi; Yadav, Deshraj; Moura, Jose M. F.; Parikh, Devi; Batra, Dhruv (2017). Visual Dialog. pp. 326–335.

- ^

船越 ,孝太郎 、渡辺 ,聖 、栗山 ,直子 、徳永 ,健 伸 「知覚 的 群 化 に基 づく参照 表現 の生成 」『自然 言語 処理 』第 13巻 第 2号 、2006年 、79–97頁 、doi:10.5715/jnlp.13.2_79。 - ^ Mogadala, Kalimuthu & Klakow 2021, p. 1216.

- ^ Kazemzadeh, Sahar; Ordonez, Vicente; Matten, Mark; Berg, Tamara (2014-10). “ReferItGame: Referring to Objects in Photographs of Natural Scenes”. Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP) (Doha, Qatar: Association for Computational Linguistics): 787–798. doi:10.3115/v1/D14-1086.

- ^ Krahmer 2012, p. 207.

- ^ a b Mao, Junhua; Huang, Jonathan; Toshev, Alexander; Camburu, Oana; Yuille, Alan; Murphy, Kevin (2016-06). “Generation and Comprehension of Unambiguous Object Descriptions”. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) (Las Vegas, NV, USA: IEEE): 11–20. doi:10.1109/CVPR.2016.9. ISBN 978-1-4673-8851-1.

- ^ Qiao 2021, p. 4427.

- ^

寺中 ,元 希 ;斎藤 ,博昭 (2015). “含意 関係 認識 におけるベクトル空間 モデルの適用 ”.自然 言語 処理 学会 21: 924. - ^ Mogadala, Kalimuthu & Klakow 2021, p. 1241.

- ^ a b Specia, Lucia; Frank, Stella; Sima'an, Khalil; Elliott, Desmond (2016-08). “A Shared Task on Multimodal Machine Translation and Crosslingual Image Description”. Proceedings of the First Conference on Machine Translation: Volume 2, Shared Task Papers (Berlin, Germany: Association for Computational Linguistics): 543–553. doi:10.18653/v1/W16-2346.

- ^ “CLEVR: A Diagnostic Dataset for Compositional Language and Elementary Visual Reasoning”. cs.stanford.edu. 2022

年 3月 25日 閲覧 。 - ^ CLEVR Dataset Generation, Meta Research, (2022-03-16) 2022

年 3月 25日 閲覧 。 - ^ Isola, Phillip; Zhu, Jun-Yan; Zhou, Tinghui; Efros, Alexei A. (2017-07). “Image-to-Image Translation with Conditional Adversarial Networks”. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR): 5967–5976. doi:10.1109/CVPR.2017.632.

- ^ a b c Mogadala, Kalimuthu & Klakow 2021, p. 1258.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1232.

- ^ a b Bakhtin, Anton; van der Maaten, Laurens; Johnson, Justin; Gustafson, Laura; Girshick, Ross (2019). “PHYRE: A New Benchmark for Physical Reasoning”. Advances in Neural Information Processing Systems (Curran Associates, Inc.) 32.

- ^ a b Johnson, Justin; Hariharan, Bharath; Van Der Maaten, Laurens; Hoffman, Judy; Fei-Fei, Li; Zitnick, C. Lawrence; Girshick, Ross (2017-10). “Inferring and Executing Programs for Visual Reasoning”. 2017 IEEE International Conference on Computer Vision (ICCV): 3008–3017. doi:10.1109/ICCV.2017.325.

- ^ a b He 2021, p. 2.

- ^ Zieliński, P.; Markowska-Kaczmar, U. (2021-10-01). “3D robotic navigation using a vision-based deep reinforcement learning model” (

英語 ). Applied Soft Computing 110: 107602. doi:10.1016/j.asoc.2021.107602. ISSN 1568-4946. - ^ a b c Anderson, Peter; Wu, Qi; Teney, Damien; Bruce, Jake; Johnson, Mark; Sunderhauf, Niko; Reid, Ian; Gould, Stephen et al. (2018-06). “Vision-and-Language Navigation: Interpreting Visually-Grounded Navigation Instructions in Real Environments”. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (Salt Lake City, UT: IEEE): 3674–3683. doi:10.1109/CVPR.2018.00387. ISBN 978-1-5386-6420-9.

- ^ Datta 2008, p. 5.

- ^ a b c

庄野 逸 (2013). “局所 画像 特徴 量 ~ SIFT, HOG を題材 に~”.映像 情報 メディア学会 誌 67 (3): 256~258. - ^ a b c Farhadi, Ali; Hejrati, Mohsen; Sadeghi, Mohammad Amin; Young, Peter; Rashtchian, Cyrus; Hockenmaier, Julia; Forsyth, David (2010). Daniilidis, Kostas; Maragos, Petros; Paragios, Nikos. eds. “Every Picture Tells a Story: Generating Sentences from Images” (

英語 ). Computer Vision – ECCV 2010 (Berlin, Heidelberg: Springer): 15–29. doi:10.1007/978-3-642-15561-1_2. ISBN 978-3-642-15561-1. - ^ a b c Hossain 2019, p. 2.

- ^ a b c d e f g h i Kafle 2019, 2.2. V&L Algorithms.

- ^ a b Vaswani, Ashish; Shazeer, Noam; Parmar, Niki; Uszkoreit, Jakob; Jones, Llion; Gomez, Aidan N; Kaiser, Łukasz; Polosukhin, Illia (2017). “Attention is All you Need”. Advances in Neural Information Processing Systems (Curran Associates, Inc.) 30.

- ^ Parmar, Niki; Vaswani, Ashish; Uszkoreit, Jakob; Kaiser, Lukasz; Shazeer, Noam; Ku, Alexander; Tran, Dustin (2018-07-03). “Image Transformer” (

英語 ). International Conference on Machine Learning (PMLR): 4055–4064. - ^ Mogadala, Kalimuthu & Klakow 2021, p. 1270.

- ^ a b c Uppal 2022, p. 161.

- ^ a b Mogadala, Kalimuthu & Klakow 2021, p. 1189.

- ^ a b c He, Kaiming; Girshick, Ross; Dollar, Piotr (2019-10). “Rethinking ImageNet Pre-Training”. 2019 IEEE/CVF International Conference on Computer Vision (ICCV) (Seoul, Korea (South): IEEE): 4917–4926. doi:10.1109/ICCV.2019.00502. ISBN 978-1-7281-4803-8.

- ^ a b Qiu 2020, p. 1872.

- ^ Devlin, Jacob; Chang, Ming-Wei; Lee, Kenton; Toutanova, Kristina (2019). “BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding” (

英語 ). Proceedings of the 2019 Conference of the North (Minneapolis, Minnesota: Association for Computational Linguistics): 4171–4186. doi:10.18653/v1/N19-1423. - ^ Qiu 2020, p. 1873.

- ^ Han 2022, p. 1.

- ^ Uppal 2022, p. 149.

- ^ Hossain 2019, pp. 4, 11.

- ^ Hossain 2019, pp. 11.

- ^ Uppal 2022, p. 153.

- ^ a b Mogadala, Kalimuthu & Klakow 2021, p. 1198.

- ^ a b Sharma 2020, p. 327.

- ^ Zhang, Jianing; Wu, Zhaochang; Zhang, Huajie; Chen, Yunfang (2020-10-01). “Visual Question Answering Based on Question Attention Model”. Journal of Physics: Conference Series 1624 (2): 022022. doi:10.1088/1742-6596/1624/2/022022. ISSN 1742-6588.

- ^ Qi 2017, p. 22.

- ^ a b Qi 2017, p. 23.

- ^ Uppal 2022, p. 155.

- ^ Zhou, Luowei; Palangi, Hamid; Zhang, Lei; Hu, Houdong; Corso, Jason; Gao, Jianfeng (2020-04-03). “Unified Vision-Language Pre-Training for Image Captioning and VQA”. Proceedings of the AAAI Conference on Artificial Intelligence 34 (07): 13041–13049. doi:10.1609/aaai.v34i07.7005. ISSN 2374-3468.

- ^ Wu 2017, p. 22.

- ^ a b Wu 2017, p. 30.

- ^ a b Latif 2019, p. 1.

- ^ a b Latif 2019, p. 2.

- ^ a b c Kapoor 2021, p. 29562.

- ^ Kapoor 2021, p. 29561.

- ^ Kapoor 2021, pp. 29563–29571.

- ^ Datta 2008, p. 52.

- ^ a b c d e f g Latif 2019, p. 17.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1261.

- ^ Li, Bowen; Qi, Xiaojuan; Lukasiewicz, Thomas; Torr, Philip (2019). “Controllable Text-to-Image Generation”. Advances in Neural Information Processing Systems (Curran Associates, Inc.) 32.

- ^ Goodfellow 2016, p. 19.

- ^ Ferraro 2015, p. 208.

- ^ Ferraro 2015.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1193.

- ^ “Im2Text: Describing Images Using 1 Million Captioned Photographs”. Vicente Ordonez. 2022

年 3月 25日 閲覧 。 - ^ Young, Peter; Lai, Alice; Hodosh, Micah; Hockenmaier, Julia (2014). “From image descriptions to visual denotations: New similarity metrics for semantic inference over event descriptions”. Transactions of the Association for Computational Linguistics 2: 67–78. doi:10.1162/tacl_a_00166.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1195.

- ^ Lin, Tsung-Yi; Maire, Michael; Belongie, Serge; Hays, James; Perona, Pietro; Ramanan, Deva; Dollár, Piotr; Zitnick, C. Lawrence (2014). Fleet, David; Pajdla, Tomas; Schiele, Bernt et al.. eds. “Microsoft COCO: Common Objects in Context” (

英語 ). Computer Vision – ECCV 2014 (Cham: Springer International Publishing): 740–755. doi:10.1007/978-3-319-10602-1_48. ISBN 978-3-319-10602-1. - ^ Chen, David; Dolan, William (2011-06). “Collecting Highly Parallel Data for Paraphrase Evaluation”. Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies (Portland, Oregon, USA: Association for Computational Linguistics): 190–200.

- ^ Wu 2017, p. 28.

- ^ a b Wu 2017, p. 33.

- ^ He 2021, p. 5.

- ^ Wu 2017, p. 34.

- ^ “Visual Question Answering” (

英語 ). Visual Question Answering. 2022年 3月 25日 閲覧 。 - ^ Tommasi, Tatiana; Patricia, Novi; Caputo, Barbara; Tuytelaars, Tinne (2017), “A Deeper Look at Dataset Bias”, in Csurka, Gabriela (

英語 ), Domain Adaptation in Computer Vision Applications, Springer International Publishing, p. 39, doi:10.1007/978-3-319-58347-1_2, ISBN 978-3-319-58347-1 - ^ Torralba, Antonio; Efros, Alexei A. (2011-06). “Unbiased look at dataset bias”. CVPR 2011: 1521–1528. doi:10.1109/CVPR.2011.5995347.

- ^ Margaret Mitchell. “Bias in the Vision and Language of Artificial Intelligence”. 2022

年 4月 8日 閲覧 。 - ^ a b Antol, Stanislaw; Agrawal, Aishwarya; Lu, Jiasen; Mitchell, Margaret; Batra, Dhruv; Zitnick, C. Lawrence; Parikh, Devi (2015-12). “VQA: Visual Question Answering”. 2015 IEEE International Conference on Computer Vision (ICCV) (Santiago, Chile: IEEE): 2425–2433. doi:10.1109/ICCV.2015.279. ISBN 978-1-4673-8391-2.

- ^ Iqbal 2020, p. 12.

- ^ Novikova, Jekaterina; Dušek, Ondřej; Cercas Curry, Amanda; Rieser, Verena (2017). “Why We Need New Evaluation Metrics for NLG” (

英語 ). Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing (Copenhagen, Denmark: Association for Computational Linguistics): 2241–2252. doi:10.18653/v1/D17-1238.

参考 文献

[書籍

[- Goodfellow, Ian; Bengio, Yoshua; Courville, Aaron (2016-11-18) (

英語 ). Deep Learning. Cambridge, MA, USA: MIT Press. ISBN 978-0-262-03561-3 - Milan Sonka; Vaclav Hlavac; Roger Boyle (2008). Image Processing, Analysis, and Machine Vision. Thomson. ISBN 978-0-495-08252-1

- Jurafsky, Daniel; Martin, James H. (2009). Speech and language processing : an introduction to natural language processing, computational linguistics, and speech recognition (Second edition ed.). Prentice Hall. ISBN 978-0-13-187321-6. OCLC 213375806

- Eisenstein, Jacob (2019). Introduction to natural language processing. Cambridge, Massachusetts: The MIT Press. ISBN 978-0-262-04284-0. OCLC 1080249173

サーベイ論文 (視覚 と自然 言語 の融合 研究 について)

[分野 全体 について

[- Ferraro, Francis; Mostafazadeh, Nasrin; Huang, Ting-Hao; Vanderwende, Lucy; Devlin, Jacob; Galley, Michel; Mitchell, Margaret (2015-09). “A Survey of Current Datasets for Vision and Language Research”. Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing (Lisbon, Portugal: Association for Computational Linguistics): 207–213. doi:10.18653/v1/D15-1021.

- Baltrušaitis, Tadas; Ahuja, Chaitanya; Morency, Louis-Philippe (2019-02). “Multimodal Machine Learning: A Survey and Taxonomy”. IEEE Transactions on Pattern Analysis and Machine Intelligence 41 (2): 423–443. doi:10.1109/TPAMI.2018.2798607. ISSN 1939-3539.

- Kafle, Kushal; Shrestha, Robik; Kanan, Christopher (2019). “Challenges and Prospects in Vision and Language Research”. Frontiers in Artificial Intelligence 2. doi:10.3389/frai.2019.00028/full. ISSN 2624-8212.

- Uppal, Shagun; Bhagat, Sarthak; Hazarika, Devamanyu; Majumder, Navonil; Poria, Soujanya; Zimmermann, Roger; Zadeh, Amir (2022-01-01). “Multimodal research in vision and language: A review of current and emerging trends” (

英語 ). Information Fusion 77: 149–171. doi:10.1016/j.inffus.2021.07.009. ISSN 1566-2535. - Mogadala, Aditya; Kalimuthu, Marimuthu; Klakow, Dietrich (2021-08-30). “Trends in Integration of Vision and Language Research: A Survey of Tasks, Datasets, and Methods” (

英語 ). Journal of Artificial Intelligence Research 71: 1183–1317. doi:10.1613/jair.1.11688. ISSN 1076-9757.

それぞれのタスクについて

[- Hossain, MD. Zakir; Sohel, Ferdous; Shiratuddin, Mohd Fairuz; Laga, Hamid (2019-02-04). “A Comprehensive Survey of Deep Learning for Image Captioning”. ACM Computing Surveys 51 (6): 1–36. doi:10.1145/3295748. ISSN 0360-0300.

- Sharma, Himanshu; Agrahari, Manmohan; Singh, Sujeet Kumar; Firoj, Mohd; Mishra, Ravi Kumar (2020-02). “Image Captioning: A Comprehensive Survey”. 2020 International Conference on Power Electronics IoT Applications in Renewable Energy and its Control (PARC): 325–328. doi:10.1109/PARC49193.2020.236619.

- Wang, Chaoyang; Zhou, Ziwei; Xu, Liang (2021-01). “An Integrative Review of Image Captioning Research” (

英語 ). Journal of Physics: Conference Series 1748 (4): 042060. doi:10.1088/1742-6596/1748/4/042060. ISSN 1742-6596. - Wu, Qi; Teney, Damien; Wang, Peng; Shen, Chunhua; Dick, Anthony; van den Hengel, Anton (2017-10-01). “Visual question answering: A survey of methods and datasets” (

英語 ). Computer Vision and Image Understanding 163: 21–40. doi:10.1016/j.cviu.2017.05.001. ISSN 1077-3142. - Datta, Ritendra; Joshi, Dhiraj; Li, Jia; Wang, James Z. (2008-04). “Image retrieval: Ideas, influences, and trends of the new age” (

英語 ). ACM Computing Surveys 40 (2): 1–60. doi:10.1145/1348246.1348248. ISSN 0360-0300. - Dureja, Aman; Pahwa, Payal (2017-12-28). “Image retrieval techniques: a survey”. International Journal of Engineering & Technology 7 (1.2): 215. doi:10.14419/ijet.v7i1.2.9231. ISSN 2227-524X.

- Latif, Afshan; Rasheed, Aqsa; Sajid, Umer; Ahmed, Jameel; Ali, Nouman; Ratyal, Naeem Iqbal; Zafar, Bushra; Dar, Saadat Hanif et al. (2019-08-26). “Content-Based Image Retrieval and Feature Extraction: A Comprehensive Review” (

英語 ). Mathematical Problems in Engineering 2019: e9658350. doi:10.1155/2019/9658350. ISSN 1024-123X. - Kapoor, Rajiv; Sharma, Deepak; Gulati, Tarun (2021-08-01). “State of the art content based image retrieval techniques using deep learning: a survey” (

英語 ). Multimedia Tools and Applications 80 (19): 29561–29583. doi:10.1007/s11042-021-11045-1. ISSN 1573-7721. - Krahmer, Emiel; van Deemter, Kees (2012-03). “Computational Generation of Referring Expressions: A Survey”. Computational Linguistics 38 (1): 173–218. doi:10.1162/COLI_a_00088.

- Qiao, Yanyuan; Deng, Chaorui; Wu, Qi (2021). “Referring Expression Comprehension: A Survey of Methods and Datasets”. IEEE Transactions on Multimedia 23: 4426–4440. doi:10.1109/TMM.2020.3042066. ISSN 1941-0077.

- He, Feijuan; Wang, Yaxian; Miao, Xianglin; Sun, Xia (2021-08-01). “Interpretable visual reasoning: A survey” (

英語 ). Image and Vision Computing 112: 104194. doi:10.1016/j.imavis.2021.104194. ISSN 0262-8856.

サーベイ論文 (コンピュータビジョンおよび自然 言語 処理 について)

[- Qiu, XiPeng; Sun, TianXiang; Xu, YiGe; Shao, YunFan; Dai, Ning; Huang, XuanJing (2020-10-01). “Pre-trained models for natural language processing: A survey” (

英語 ). Science China Technological Sciences 63 (10): 1872–1897. doi:10.1007/s11431-020-1647-3. ISSN 1869-1900. - Khan, Salman; Naseer, Muzammal; Hayat, Munawar; Zamir, Syed Waqas; Khan, Fahad Shahbaz; Shah, Mubarak (2021-12-07). “Transformers in Vision: A Survey”. ACM Computing Surveys. doi:10.1145/3505244. ISSN 0360-0300.

- Han, Kai; Wang, Yunhe; Chen, Hanting; Chen, Xinghao; Guo, Jianyuan; Liu, Zhenhua; Tang, Yehui; Xiao, An et al. (2022). “A Survey on Vision Transformer”. IEEE Transactions on Pattern Analysis and Machine Intelligence. doi:10.1109/TPAMI.2022.3152247. ISSN 0162-8828.

- Iqbal, Touseef; Qureshi, Shaima (2020-04-13). “The survey: Text generation models in deep learning” (

英語 ). Journal of King Saud University - Computer and Information Sciences. doi:10.1016/j.jksuci.2020.04.001. ISSN 1319-1578.