情報 じょうほう 量 りょう エントロピー (英 えい entropy )は、情報 じょうほう 理論 りろん 概念 がいねん 事象 じしょう 起 お 際 さい 起 お 表 あらわ 尺度 しゃくど 風 かぜ 音 おと 起 お 知 し 情報 じょうほう 逆 ぎゃく 珍 めずら 曲 きょく 演奏 えんそう 起 お 多 おお 情報 じょうほう 含 ふく 考 かんが 情報 じょうほう 量 りょう 本質 ほんしつ 的 てき 程度 ていど 情報 じょうほう 持 も 尺度 しゃくど

なおここでいう「情報 じょうほう 起 お 確 かく 率 りつ 決 き 数学 すうがく 的 てき 量 りょう 個人 こじん 社会 しゃかい 有用 ゆうよう 性 せい 無関係 むかんけい 自分 じぶん 宝 たから 当 あ 見知 みし 宝 たから 当 あ 前者 ぜんしゃ 方 ほう 有用 ゆうよう 情報 じょうほう 見 み 両者 りょうしゃ 情報 じょうほう 量 りょう 全 まった 同 おな 宝 たから 当 あ 確 かく 率 りつ 所与 しょよ 条件 じょうけん 一定 いってい 誰 だれ 同 おな

自己 じこ 情報 じょうほう 量 りょう 自己 じこ 平均 へいきん 情報 じょうほう 量 りょう [ 編集 へんしゅう ] それぞれのできごとの情報 じょうほう 量 りょう 情報 じょうほう 量 りょう 平均 へいきん 値 ち 情報 じょうほう 量 りょう 呼 よ 両者 りょうしゃ 区別 くべつ 場合 ばあい 前者 ぜんしゃ 自己 じこ 情報 じょうほう 量 りょう 自己 じこ 後者 こうしゃ 平均 へいきん 情報 じょうほう 量 りょう エントロピー とも)と呼 よ

自己 じこ 情報 じょうほう 量 りょう [ 編集 へんしゅう ] 事象 じしょう

E

{\displaystyle E}

起 お 確 かく 率 りつ

P

(

E

)

{\displaystyle P(E)}

事象 じしょう

E

{\displaystyle E}

起 お 知 し 受 う 取 と 自己 じこ 情報 じょうほう 量 りょう

I

(

E

)

{\displaystyle I(E)}

以下 いか 定義 ていぎ

I

(

E

)

=

log

1

P

(

E

)

=

−

log

P

(

E

)

{\displaystyle I(E)=\log {\frac {1}{P(E)}}=-\log P(E)}

確 かく 率 りつ

0

≤

P

(

E

)

≤

1

{\displaystyle 0\leq P(E)\leq 1}

自己 じこ 情報 じょうほう 量 りょう

I

(

E

)

{\displaystyle I(E)}

非負 ひふ 対数 たいすう 単調 たんちょう 増加 ぞうか 性 せい 起 お 事象 じしょう 生起 せいき 確 かく 率 りつ 低 ひく 事象 じしょう 情報 じょうほう 量 りょう 値 ね 大 おお

対数 たいすう 底 そこ 何 なに 選 えら 情報 じょうほう 量 りょう 値 ね 定数 ていすう 倍 ばい 変 か 本質 ほんしつ 的 てき 差 さ 慣習 かんしゅう 的 てき 底 そこ 選 えら 多 おお 底 そこ 場合 ばあい

1

/

2

n

{\displaystyle 1/2^{n}}

確 かく 率 りつ 起 お 事象 じしょう 情報 じょうほう 量 りょう

n

{\displaystyle n}

直観 ちょっかん 的 てき 意味 いみ [ 編集 へんしゅう ] 整数 せいすう

u

{\displaystyle u}

対 たい

u

{\displaystyle u}

対数 たいすう

log

m

u

{\displaystyle \log _{m}u}

m

{\displaystyle m}

進 すすむ 法 ほう

u

{\displaystyle u}

桁数 けたすう 等 ひと 値 ね 表 あらわ 確 かく 率 りつ

1

/

u

{\displaystyle 1/u}

起 お 事象 じしょう 情報 じょうほう 量 りょう

u

{\displaystyle u}

桁数 けたすう

情報 じょうほう 量 りょう 加法 かほう 性 せい [ 編集 へんしゅう ] 情報 じょうほう 量 りょう 加法 かほう 性 せい 持 も 独立 どくりつ 事象 じしょう 対 たい 事象 じしょう 起 お 情報 じょうほう 量 りょう 情報 じょうほう 量 りょう 情報 じょうほう 量 りょう 和 やわ 以下 いか 証明 しょうめい

I

(

A

,

B

)

=

−

log

P

(

A

,

B

)

=

−

log

(

P

(

A

)

⋅

P

(

B

)

)

=

−

(

log

P

(

A

)

+

log

P

(

B

)

)

=

I

(

A

)

+

I

(

B

)

{\displaystyle I(A,B)=-\log P(A,B)=-\log(P(A)\cdot P(B))=-(\log P(A)+\log P(B))=I(A)+I(B)}

例 たと 枚 まい トランプ から無作為 むさくい 枚 まい 取 と 出 だ 試行 しこう 考 かんが 取 と 出 だ 事象 じしょう 情報 じょうほう 量 りょう 前述 ぜんじゅつ 定義 ていぎ log 52 であると分 わ 取 と 出 だ スート はハートである」という事象 じしょう 取 と 出 だ 数字 すうじ 事象 じしょう 二 ふた 考 かんが 前者 ぜんしゃ 情報 じょうほう 量 りょう log 4 、後者 こうしゃ log 13 である。この両者 りょうしゃ 和 わ log 4 + log 13 = log (4×13) = log 52 となり、「取 と 出 だ 事象 じしょう 情報 じょうほう 量 りょう 等 ひと 独立 どくりつ 情報 じょうほう 和 わ 全体 ぜんたい 情報 じょうほう 量 りょう 一致 いっち 直感 ちょっかん 的 てき 要請 ようせい 合致 がっち

情報 じょうほう 量 りょう 対 たい 直感 ちょっかん 的 てき 要請 ようせい 発生 はっせい 確 かく 率 りつ 低 ひく 大 おお 単調 たんちょう 減少 げんしょう 性 せい 確 かく 率 りつ 関 かん 連続 れんぞく 的 てき 変化 へんか 連続 れんぞく 性 せい 独立 どくりつ 同時 どうじ 事象 じしょう 情報 じょうほう 量 りょう 周辺 しゅうへん 事象 じしょう 情報 じょうほう 量 りょう 和 やわ 等 ひと 加法 かほう 性 せい 三 さん 条件 じょうけん 挙 あ 条件 じょうけん 満 み 関数 かんすう コーシーの函数 かんすう 方程式 ほうていしき を利用 りよう

C

log

p

{\displaystyle C\log p}

一意 いちい 求 もと 情報 じょうほう 量 りょう 定義 ていぎ 上記 じょうき 条件 じょうけん 一意 いちい 導出 どうしゅつ 典型 てんけい 的 てき 対数 たいすう 底 そこ p =1/2設定 せってい C=-1 )する。

平均 へいきん 情報 じょうほう 量 りょう [ 編集 へんしゅう ]

(

Ω おめが ,

F

,

P

)

{\displaystyle (\Omega ,{\mathcal {F}},P)}

確 かく 率 りつ 空間 くうかん 全 ぜん 事象 じしょう Ω おめが 分割 ぶんかつ

A

i

{\displaystyle A_{i}}

与 あた [2] 各 かく 事象 じしょう

A

i

∈

Ω おめが

{\displaystyle A_{i}\in \Omega }

自己 じこ 情報 じょうほう 量 りょう

I

(

A

i

)

{\displaystyle I(A_{i})}

定義 ていぎ 値 ね

H

(

P

)

=

∑

A

i

∈

Ω おめが

P

(

A

i

)

I

(

A

i

)

=

−

∑

A

i

∈

Ω おめが

P

(

A

i

)

log

P

(

A

i

)

{\displaystyle H(P)=\sum _{A_{i}\in \Omega }P(A_{i})\ I(A_{i})=-\sum _{A_{i}\in \Omega }P(A_{i})\log P(A_{i})}

を確 かく 率 りつ 測度 そくど P のエントロピー H (P )呼 よ 平均 へいきん 情報 じょうほう 量 りょう シャノン情報 じょうほう 量 りょう 、情報 じょうほう 論 ろん

P

(

A

i

)

=

0

{\displaystyle P(A_{i})=0}

P

(

A

i

)

log

P

(

A

i

)

=

0

{\displaystyle P(A_{i})\log P(A_{i})=0}

lim

p

→

0

+

p

log

p

=

0

{\displaystyle \lim _{p\to 0+}{p\log p}=0}

また、離散 りさん 型 がた 確 かく 率 りつ 変数 へんすう X が確 かく 率 りつ 分布 ぶんぷ P に従 したが 場合 ばあい X のエントロピー H (X )自己 じこ 情報 じょうほう 量 りょう I の期待 きたい 値 ち 定義 ていぎ

H

(

X

)

=

E

P

[

I

(

X

)

]

=

−

∑

x

∈

X

f

X

(

x

)

log

f

X

(

x

)

{\displaystyle H(X)=\mathbb {E} _{P}[I(X)]=-\sum _{x\in X}f_{X}(x)\log f_{X}(x)}

である[3] f X X の確 かく 率 りつ 質量 しつりょう 関数 かんすう [4]

0

≦

I

(

⋅

)

{\displaystyle 0\leqq I(\cdot )}

常 つね 非負 ひふ

確 かく 率 りつ 変数 へんすう X と Y の組 くみ (X , Y ) も確 かく 率 りつ 変数 へんすう 確 かく 率 りつ 変数 へんすう 値 ね 発生 はっせい 確 かく 率 りつ 同時 どうじ 確 かく 率 りつ

P

X

,

Y

(

X

,

Y

)

{\displaystyle P_{X,Y}(X,Y)}

(X , Y ) のエントロピー

H

(

X

,

Y

)

{\displaystyle H(X,Y)}

H

(

X

,

Y

)

=

E

P

X

,

Y

[

I

(

X

,

Y

)

]

=

−

∑

(

x

,

y

)

∈

(

X

,

Y

)

P

X

,

Y

(

x

,

y

)

log

P

X

,

Y

(

x

,

y

)

{\displaystyle H(X,Y)=\mathbb {E} _{P_{X,Y}}[I(X,Y)]=-\sum _{(x,y)\in (X,Y)}P_{X,Y}(x,y)\log P_{X,Y}(x,y)}

になる。これを結合 けつごう 呼 よ

(X , Y ) が互 たが 独立 どくりつ 確 かく 率 りつ 変数 へんすう 場合 ばあい

H

(

X

,

Y

)

{\displaystyle H(X,Y)}

H

(

X

)

+

H

(

Y

)

{\displaystyle H(X)+H(Y)}

一致 いっち 全体 ぜんたい 情報 じょうほう 量 りょう

H

(

X

,

Y

)

{\displaystyle H(X,Y)}

確 かく 率 りつ 変数 へんすう 情報 じょうほう 量 りょう 和 やわ

しかし、 X と Y が互 たが 独立 どくりつ 場合 ばあい

H

(

X

,

Y

)

{\displaystyle H(X,Y)}

H

(

X

)

+

H

(

Y

)

{\displaystyle H(X)+H(Y)}

一致 いっち 前者 ぜんしゃ 後者 こうしゃ 方 ほう 大 おお 値 ね 両者 りょうしゃ 情報 じょうほう 量 りょう 差 さ 相互 そうご 情報 じょうほう 量 りょう 呼 よ

I

(

X

,

Y

)

=

H

(

X

)

+

H

(

Y

)

−

H

(

X

,

Y

)

{\displaystyle I(X,Y)=H(X)+H(Y)-H(X,Y)}

で表 あらわ 相互 そうご 情報 じょうほう 量 りょう 常 つね 非負 ひふ 値 ね

事象 じしょう B が生 しょう 条件下 じょうけんか 事象 じしょう A の条件 じょうけん 付 つ 情報 じょうほう 量 りょう

−

log

Pr

(

A

∣

B

)

{\displaystyle -\log \Pr(A\mid B)}

定 さだ 確 かく 率 りつ 変数 へんすう X が与 あた 事象 じしょう

X

=

x

{\displaystyle X=x}

条件 じょうけん 付 つ 情報 じょうほう 量 りょう

−

log

Pr

(

X

=

x

∣

B

)

{\displaystyle -\log \Pr(X=x\mid B)}

x に関 かん 加重 かじゅう 平均 へいきん 条件 じょうけん 付 つ 言 い

H

(

X

∣

B

)

=

E

P

X

∣

B

[

I

(

X

∣

B

)

]

=

−

∑

x

∈

X

Pr

(

X

=

x

∣

B

)

log

Pr

(

X

=

x

∣

B

)

{\displaystyle H(X\mid B)=\mathbb {E} _{P_{X\mid B}}[I(X\mid B)]=-\sum _{x\in X}\Pr(X=x\mid B)\log \Pr(X=x\mid B)}

で表 あらわ

さらに確 かく 率 りつ 変数 へんすう Y が与 あた 事象 じしょう

Y

=

y

{\displaystyle Y=y}

生 しょう 条件下 じょうけんか 条件 じょうけん 付 つ

H

(

X

∣

Y

=

y

)

{\displaystyle H(X\mid Y=y)}

y に関 かん 加重 かじゅう 平均 へいきん

H

(

X

∣

Y

)

=

∑

y

∈

Y

Pr

(

Y

=

y

)

H

(

X

∣

Y

=

y

)

=

−

∑

x

∈

X

,

y

∈

Y

Pr

(

X

=

x

,

Y

=

y

)

log

Pr

(

X

=

x

∣

Y

=

y

)

{\displaystyle H(X\mid Y)=\sum _{y\in Y}\Pr(Y=y)H(X\mid Y=y)=-\sum _{x\in X,y\in Y}\Pr(X=x,Y=y)\log {\Pr(X=x\mid Y=y)}}

も、やはり条件 じょうけん 付 つ 呼 よ

エントロピーの基本 きほん 的 てき 性質 せいしつ [ 編集 へんしゅう ] 情報 じょうほう 量 りょう 確 かく 率 りつ 決 き 情報 じょうほう 量 りょう 非負 ひふ 値 ね 無限 むげん 大 だい 取 と nビットのビット列 びっとれつ 空間 くうかん 情報 じょうほう 源 げん 一様 いちよう 限 かぎ 方法 ほうほう ビット列 びっとれつ 選 えら 以下 いか 必要 ひつよう 十 じゅう 分 ふん 条件 じょうけん ビット列 びっとれつ 一様 いちよう 選 えら

確 かく 率 りつ 変数 へんすう 独立 どくりつ 必要 ひつよう 十 じゅう 分 ふん 条件 じょうけん

H

(

X

)

+

H

(

Y

)

=

H

(

X

,

Y

)

{\displaystyle H(X)+H(Y)=H(X,Y)}

成立 せいりつ あるコインを投 な 表 ひょう 出 で 確 かく 率 りつ

p

{\displaystyle p}

裏 うら 出 で 確 かく 率 りつ

1

−

p

{\displaystyle 1-p}

投 な 得 え 平均 へいきん 情報 じょうほう 量 りょう

H

(

X

)

=

−

p

log

p

−

(

1

−

p

)

log

(

1

−

p

)

{\displaystyle H(X)=-p\log {p}-(1-p)\log {(1-p)}}

である。

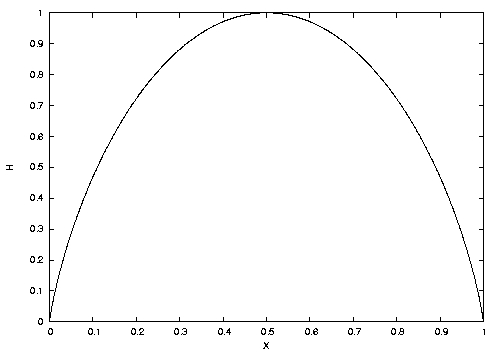

この関数 かんすう

f

(

p

)

=

−

p

log

p

−

(

1

−

p

)

log

(

1

−

p

)

{\displaystyle f(p)=-p\log {p}-(1-p)\log {(1-p)}}

エントロピー関数 かんすう と呼 よ

図 ず 見 み 分 わ

p

=

0

{\displaystyle p=0}

p

=

1

{\displaystyle p=1}

H はゼロである。つまり、コインを投 な 前 まえ 裏 うら 表 ひょう 出 で 確実 かくじつ 分 わ 得 え 平均 へいきん 情報 じょうほう 量 りょう H が最大 さいだい

p

=

1

/

2

{\displaystyle p=1/2}

一般 いっぱん 事象 じしょう 等 とう 確 かく 率 りつ 最大 さいだい

連続 れんぞく 系 けい [ 編集 へんしゅう ] 実 じつ 数値 すうち 取 と 確 かく 率 りつ 変数 へんすう X の確 かく 率 りつ 密度 みつど 関数 かんすう p (x )とするとき、X のエントロピーを

h

(

X

)

=

−

∫

−

∞

∞

p

(

x

)

log

p

(

x

)

d

x

{\displaystyle h(X)=-\int _{-\infty }^{\infty }p(x)\log p(x)dx}

によって定義 ていぎ

X が有限 ゆうげん 集合 しゅうごう 値 ね 取 と 確 かく 率 りつ 変数 へんすう 場合 ばあい X のシャノン情報 じょうほう 量 りょう

H

(

X

)

{\displaystyle H(X)}

定義 ていぎ X がn 通 とお 値 ね 取 と

H

(

X

)

{\displaystyle H(X)}

h

(

X

)

{\displaystyle h(X)}

h

(

X

)

=

H

(

U

n

)

−

H

(

X

)

{\displaystyle h(X)=H(U_{n})-H(X)}

を満 み

ただし、ここで

U

n

{\displaystyle U_{n}}

n 元 もと 集合 しゅうごう 上 じょう 一様 いちよう 分布 ぶんぷ

H

(

U

n

)

=

log

n

{\displaystyle H(U_{n})=\log n}

Ω おめが

{\displaystyle \Omega }

台 だい 有限 ゆうげん 集合 しゅうごう 確 かく 率 りつ 空間 くうかん P を

Ω おめが

{\displaystyle \Omega }

上 うえ 確 かく 率 りつ 分布 ぶんぷ

α あるふぁ

{\displaystyle \alpha }

非負 ひふ 実数 じっすう

α あるふぁ ≠

1

{\displaystyle \alpha \neq 1}

P のdegee

α あるふぁ

{\displaystyle \alpha }

Renyiエントロピー を

H

α あるふぁ

(

P

)

=

log

(

∑

A

∈

Ω おめが

P

(

A

)

α あるふぁ

)

1

−

α あるふぁ

{\displaystyle H_{\alpha }(P)={\frac {\log(\sum _{A\in \Omega }P(A)^{\alpha })}{1-\alpha }}}

によって定義 ていぎ

α あるふぁ =

1

,

∞

{\displaystyle \alpha =1,\infty }

場合 ばあい

{

H

1

(

P

)

=

lim

α あるふぁ →

1

H

α あるふぁ

(

P

)

H

∞

(

P

)

=

lim

α あるふぁ →

∞

H

α あるふぁ

(

P

)

{\displaystyle \left\{{\begin{array}{lll}H_{1}(P)&=\lim _{\alpha \to 1}&H_{\alpha }(P)\\H_{\infty }(P)&=\lim _{\alpha \to \infty }&H_{\alpha }(P)\end{array}}\right.}

によって定義 ていぎ

単 たん Renyiエントロピー と言 い 場合 ばあい

H

2

(

P

)

{\displaystyle H_{2}(P)}

意味 いみ 多 おお

さらに、確 かく 率 りつ 変数 へんすう X が確 かく 率 りつ 分布 ぶんぷ P に従 したが

H

α あるふぁ

(

X

)

{\displaystyle H_{\alpha }(X)}

H

α あるふぁ

(

X

)

=

H

α あるふぁ

(

P

)

{\displaystyle H_{\alpha }(X)=H_{\alpha }(P)}

定義 ていぎ

Renyiエントロピーは以下 いか 性質 せいしつ 満 み

H

0

(

P

)

=

log

#

Ω おめが

{\displaystyle H_{0}(P)=\log \#\Omega }

成立 せいりつ

H

1

(

P

)

{\displaystyle H_{1}(P)}

情報 じょうほう 量 りょう

H

(

P

)

=

−

∑

A

∈

Ω おめが

P

(

A

)

log

P

(

A

)

{\displaystyle H(P)=-\sum _{A\in \Omega }P(A)\log P(A)}

一致 いっち

α あるふぁ

{\displaystyle \alpha }

以上 いじょう 整数 せいすう 場合 ばあい

H

α あるふぁ

(

P

)

=

1

1

−

α あるふぁ

log

Pr

(

X

1

=

⋯

=

X

α あるふぁ

)

{\displaystyle H_{\alpha }(P)={\frac {1}{1-\alpha }}\log \Pr(X_{1}=\cdots =X_{\alpha })}

成立 せいりつ

X

1

,

…

,

X

α あるふぁ

{\displaystyle X_{1},\ldots ,X_{\alpha }}

確 かく 率 りつ 分布 ぶんぷ

P

{\displaystyle P}

従 したが 独立 どくりつ 同 どう 一 いち 分布 ぶんぷ

Pr

(

X

1

=

⋯

=

X

α あるふぁ

)

{\displaystyle \Pr(X_{1}=\cdots =X_{\alpha })}

x

1

,

…

,

x

α あるふぁ

{\displaystyle x_{1},\ldots ,x_{\alpha }}

X

1

,

…

,

X

α あるふぁ

{\displaystyle X_{1},\ldots ,X_{\alpha }}

従 したが 選 えら

x

1

=

⋯

=

x

α あるふぁ

{\displaystyle x_{1}=\cdots =x_{\alpha }}

成立 せいりつ 確 かく 率 りつ

H

∞

(

P

)

=

min

A

∈

Ω おめが

{

−

log

P

(

A

)

}

{\displaystyle H_{\infty }(P)=\min _{A\in \Omega }\{-\log P(A)\}}

成立 せいりつ

H

∞

(

P

)

{\displaystyle H_{\infty }(P)}

minエントロピー ともいう。「エントロピー」の概念 がいねん 1865年 ねん にルドルフ・クラウジウス がギリシャ語 ご 変換 へんかん 意味 いみ 言葉 ことば 語源 ごげん 熱 ねつ 力学 りきがく 気体 きたい 状態 じょうたい 量 りょう 導入 どうにゅう 統計 とうけい 力学 りきがく 微視的 びしてき 状態 じょうたい 数 すう 対数 たいすう 比例 ひれい 量 りょう 表 あらわ 1929年 ねん にはレオ・シラード が、気体 きたい 情報 じょうほう 観測 かんそく 者 しゃ 獲得 かくとく 統計 とうけい 力学 りきがく 間 あいだ 直接 ちょくせつ 関係 かんけい 示 しめ 現在 げんざい 呼 よ 量 りょう 統計 とうけい 力学 りきがく k ln 2 に対応 たいおう 関係 かんけい 導 みちび [5]

現在 げんざい 情報 じょうほう 理論 りろん 直接 ちょくせつ 導入 どうにゅう 1948年 ねん のクロード・シャノン によるもので、その論文 ろんぶん 通信 つうしん 数学 すうがく 的 てき 理論 りろん 概念 がいねん 情報 じょうほう 理論 りろん 応用 おうよう 自身 じしん 熱 ねつ 統計 とうけい 力学 りきがく 概念 がいねん 関連 かんれん 概念 がいねん 使 つか 知 し 定義 ていぎ 到達 とうたつ 名称 めいしょう 考 かんが 同僚 どうりょう フォン・ノイマン が、熱 ねつ 統計 とうけい 力学 りきがく 似 に 示唆 しさ 統計 とうけい 何 なに 理解 りかい 人 ひと 少 すく 議論 ぎろん 有利 ゆうり 語 かた [7] [8] 会話 かいわ 認 みと 影響 えいきょう 否定 ひてい [9]

なお、シャノン以前 いぜん ラルフ・ハートレー が1928年 ねん に、集合 しゅうごう A に対 たい

log

#

A

{\displaystyle \log \#A}

量 りょう 考察 こうさつ

#

A

{\displaystyle \#A}

A の元 もと 数 かず

log

#

A

{\displaystyle \log \#A}

A 上 うえ 一様 いちよう 分布 ぶんぷ 一致 いっち 現在 げんざい

log

#

A

{\displaystyle \log \#A}

A のハートレー・エントロピー と呼 よ [10]

情報 じょうほう 量 りょう 本来 ほんらい 無 む 次元 じげん 量 りょう 対数 たいすう 底 そこ 何 なに 用 もち 値 ね 異 こと 単位 たんい 付 つ 区別 くべつ 前述 ぜんじゅつ 情報 じょうほう 量 りょう 確 かく 率 りつ 逆数 ぎゃくすう 桁数 けたすう 期待 きたい 値 ち 単位 たんい 桁数 けたすう 流用 りゅうよう 為 ため 対数 たいすう 底 そこ e 、10を選 えら 情報 じょうほう 量 りょう 単位 たんい ビット ナット (nat)、ディット (dit)である。

また、今 いま 主流 しゅりゅう 年 ねん 日本工業規格 にほんこうぎょうきかく 国際 こくさい 規格 きかく ISO /IEC 2382-16:1996と一致 いっち 量 りょう 表 あらわ 単位 たんい 別 べつ 定 さだ

対数 たいすう 底 そこ 単位 たんい

底 そこ 通常 つうじょう 単位 たんい JISおよびISOが定 さだ 単位 たんい

備考 びこう

2

ビット (bit)

シャノン (shannon)lb, 二 に 進 しん 対数 たいすう

e =2.718…ナット (nat)

ナット (nat)ln, 自然 しぜん 対数 たいすう

10

ディット (dit)

ハートレー (hartley)lg, 常用 じょうよう 対数 たいすう

単位 たんい 名称 めいしょう 情報 じょうほう 量 りょう 概念 がいねん 提案 ていあん クロード・シャノン 、ラルフ・ハートレー にちなむ。

^ Gray, Robert M. (2013-03-14) (英語 えいご Entropy and Information Theory ISBN 978-1-4757-3982-4 . https://books.google.co.jp/books?id=ZoTSBwAAQBAJ&pg=PA23&q=entropy+as+a+function+of+the+partition ^ この分割 ぶんかつ 離散 りさん 型 がた 確 かく 率 りつ 変数 へんすう 確 かく 率 りつ 質量 しつりょう 関数 かんすう 誘導 ゆうどう [1]

^ Cover, Thomas M.; Thomas, Joy A. (2012-11-28) (英語 えいご Elements of Information Theory ISBN 978-1-118-58577-1 . https://books.google.co.jp/books?id=VWq5GG6ycxMC&pg=PA14 ^ f X x )

P

X

(

x

)

=

P

(

X

=

x

)

=

P

(

{

ω おめが ∈

Ω おめが ∣

X

(

ω おめが )

=

x

}

)

{\displaystyle P_{X}(x)=P(X=x)=P(\{\omega \in \Omega \mid X(\omega )=x\})}

書 か ^ Szilard, L. (1929) "Über die Entropieverminderung in einem Thermodynamischen System bei Eingriffen Intelligenter Wesen", Zeitschrift für Physik 53 :840–856

^ 『ファインマン計算 けいさん 機 き 科学 かがく 脚注 きゃくちゅう 伝 いつた 断 ことわ 説 せつ 紹介 しょうかい

^ 韓 かん 太 ふとし 舜 しゅん 小林 こばやし 欣吾 きんご 情報 じょうほう 符号 ふごう 数理 すうり ^ CLAUDE E. SHANNON: An Interview Conducted by Robert Price, 28 July 1982 ^ なお、JIS X 0016:1997 で定義 ていぎ 選択 せんたく 情報 じょうほう 量 りょう 同 おな 定義 ていぎ 互 たが 排反 はいはん 事象 じしょう 成 な 有限 ゆうげん 集合 しゅうごう 中 ちゅう 事象 じしょう 数 かず 対数 たいすう

![{\displaystyle H(X)=\mathbb {E} _{P}[I(X)]=-\sum _{x\in X}f_{X}(x)\log f_{X}(x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/df3934e20d3afcc3f3153e97d7ba033210af7fa1)

![{\displaystyle H(X,Y)=\mathbb {E} _{P_{X,Y}}[I(X,Y)]=-\sum _{(x,y)\in (X,Y)}P_{X,Y}(x,y)\log P_{X,Y}(x,y)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/56a1bcb8cf1ab9f462c7646b2f2c8af9706775a0)

![{\displaystyle H(X\mid B)=\mathbb {E} _{P_{X\mid B}}[I(X\mid B)]=-\sum _{x\in X}\Pr(X=x\mid B)\log \Pr(X=x\mid B)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7efcbea13b150101ca042e684f515542306bcba8)